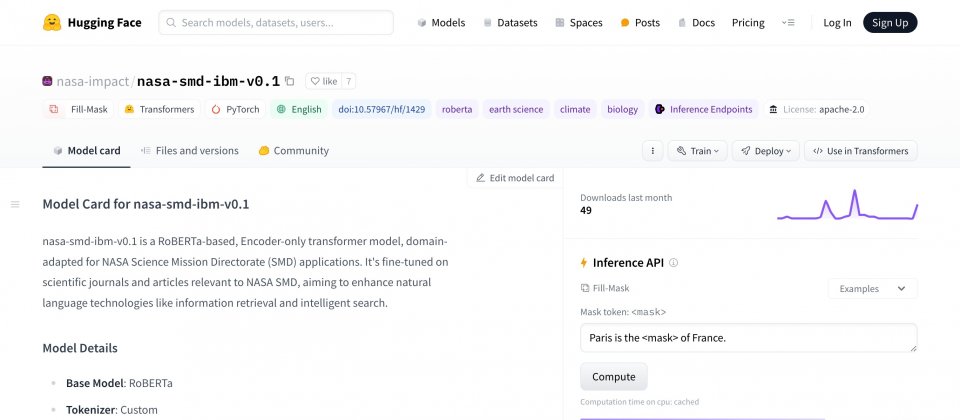

IBM与NASA合作创建Transformer架构大型语言模型,针对科学文献进行训练,提高包括分类、实体撷取、问答和资讯检索等各种科学自然语言理解任务的效能。目前相关模型已经在Hugging Face上开源,供科学与学术社群使用。

研究人员解释,大型语言模型的能力来自于对语言的统计理解。这些模型接受遮罩语言模型任务训练,借由重构已被遮蔽单字的句子来进行学习。研究人员借由随机遮蔽句子中的单词,要求模型预测被遮蔽的单字,而这有助于模型理解单词之间的关系,以及这些单词如何共同决定句子的意思。

在这个过程,标记器(Tokenizer)是一个重要的工具,可以将单字分解成模型可以理解的单位,对于模型学习大量词汇非常重要。IBM表示,使用维基百科或是BooksCorpus等资料训练标记器,通常对通用文字标记器很有效,但在科学领域,需要能够处理像是Phosphatidylcholine这种专业术语的标记器。

科学领域的文本经常包含特殊术语和复合词,一般标记器难以正确处理这些词,因此训练针对专门领域的标记器,对于提高模型在特定领域的表现非常重要。研究人员使用来自天文物理学、地球科学与太阳圈物理学(Heliophysics)等多个专业领域的资料集的600亿个Token来训练模型。

科学文献用的标记器与通用标记器有很大的不同,科学文献用的标记器要能够辨识Axes和Polycrystalline这类科学术语,IBM-NASA新开发的模型,其所处理的5万个Token中,有一半都是Hugging Face其他开源的RoBERTa模型未曾出现的。

在用于评估模型处理生物医学任务表现的基准测试BLURB,IBM-NASA模型的分数也较其他开源的RoBERTa模型高出5%。另外,该模型在内部科学问答的基准测试的F1分数提高了2.4%,在地球科学实体辨识的内部测试上,也改进了5.5%。

这个IBM-NASA编码器模型可针对许多非生成式语言任务微调,并且透过检索增强生成(RAG)技术生成资讯丰富的嵌入,用于文件检索任务上。研究人员利用编码器模型建立检索器模型,以产生资讯丰富的嵌入,映射文字对(Pairs of Text)之间的相似性,使得检索模型学习根据问题,找出最相关的文件或是资讯。

而研究人员用来训练检索模型的文字对有2.68亿笔,包括标题、摘要以及问题和答案,使其能够良好地处理NASA所准备的问题测试集,与经过类似微调的RoBERTa模型相比,检索模型效能提升了6.5%,与另一种开源嵌入模型BGE-base相比,效能也上升5%。

IBM与NASA的研究人员透过专门的训练资料、自订标记器和特别的训练方法,强化科学文献用的大型语言模型。现在编码器模型和检索器模型都已经在Hugging Face上开源,IBM也与NASA进一步合作,将这些模型用于强化科学搜寻引擎。