Meta

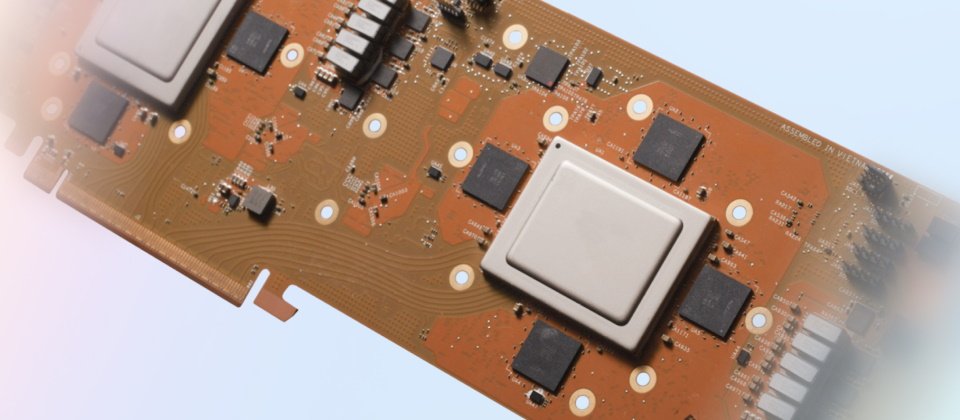

Meta本周公布下一代AI晶片Meta训练与推论加速器(Meta Training and Inference Accelerator,MTIA),为软体大厂自制晶片再添一员。

Meta去年5月公布第一代MTIA,是为自家AI负载作业,特别是为Meta平台产品(如脸书)的深度学习推荐模型而设计。MTIA v1有助于改进基础架构的运算效率,并且更能支援工程师开发AI模型。用途上,下一代MITA则将支援内容排序及广告推荐内容的底层模型运算。

最新一代MITA仍将由台积电代工,但采用5奈米制程(第一代为7奈米),体积也比较大以容纳更多处理核心。技术架构上,新一代晶片包含8x8矩阵的运算元件(PE)。由于稀疏运算相关的管线(pipelining)架构改进,加上更大的本地PE储存、晶片SRAM、频宽和LPDDR5,使新晶片的密集运算效能和稀疏运算效能较第一代提高3.5倍及7倍。而晶片上网路(network on chip,NoC)架构的改良,可在低延迟情况下协调不同PE,协助MTIA支援更多更复杂的AI负载。

-2.png)

根据Meta提供的数据,下一代MTIA平均时脉(1.35GHz vs. 800 MHz)、记忆体(128MB vs. 64MB)、主机连线速度(PCIe Gen5 vs. PCIe Gen4)都更优异,不过散热设计功耗(TDP)则较前代更高(90W vs. 25W)意谓可能更为耗电。

软体架构上,新一代MTIA延续前代设计,包括整合PyTorch 2.0及图形层捕捉、分析、转换和撷取机制(如TorchDynamo, torch.export)等,一致化的完整软体堆叠架构确保新晶片可和MTIA v1平台上开发的程式码完全相容。Meta表示,这设计使其可在几天内将运算环境转换到新晶片上;不到9个月内,已部署到Meta 16个云端区域资料中心执行AI模型。

Meta希望借由自制晶片减少对Nvidia的依赖,同时持续推进AI能力,包括训练下一代大型语言模型(LLM)。Meta高层本周也在一场活动上预告,将在下个月开源释出下世代大型语言模型Llama 3。Meta期望在下个月开始部署下一代基础模型Llama 3的最新套件。Llama 3家族包含多个能力及特性不同的AI模型,将陆续于今年内释出,而且「很快就会启动」。