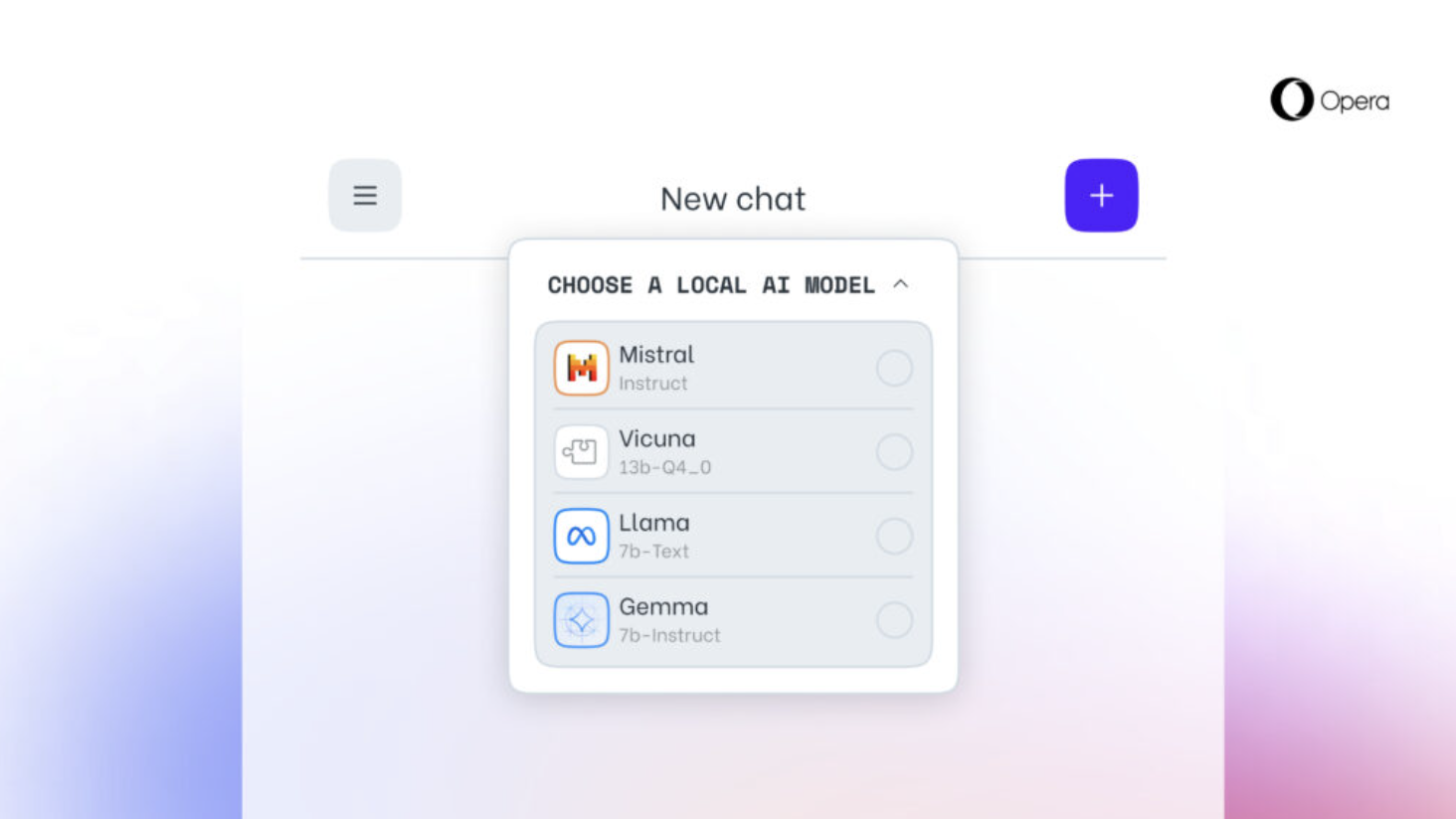

Opera 近日宣布,其将在开发者频道的 Opera One 浏览器中添加对 150 个本地 LLM 模型的实验性支持。支持模型包括:

-

Meta 的 Llama

-

Vicuna

-

Google 的 Gemma

-

Mistral AI 的 Mixtral

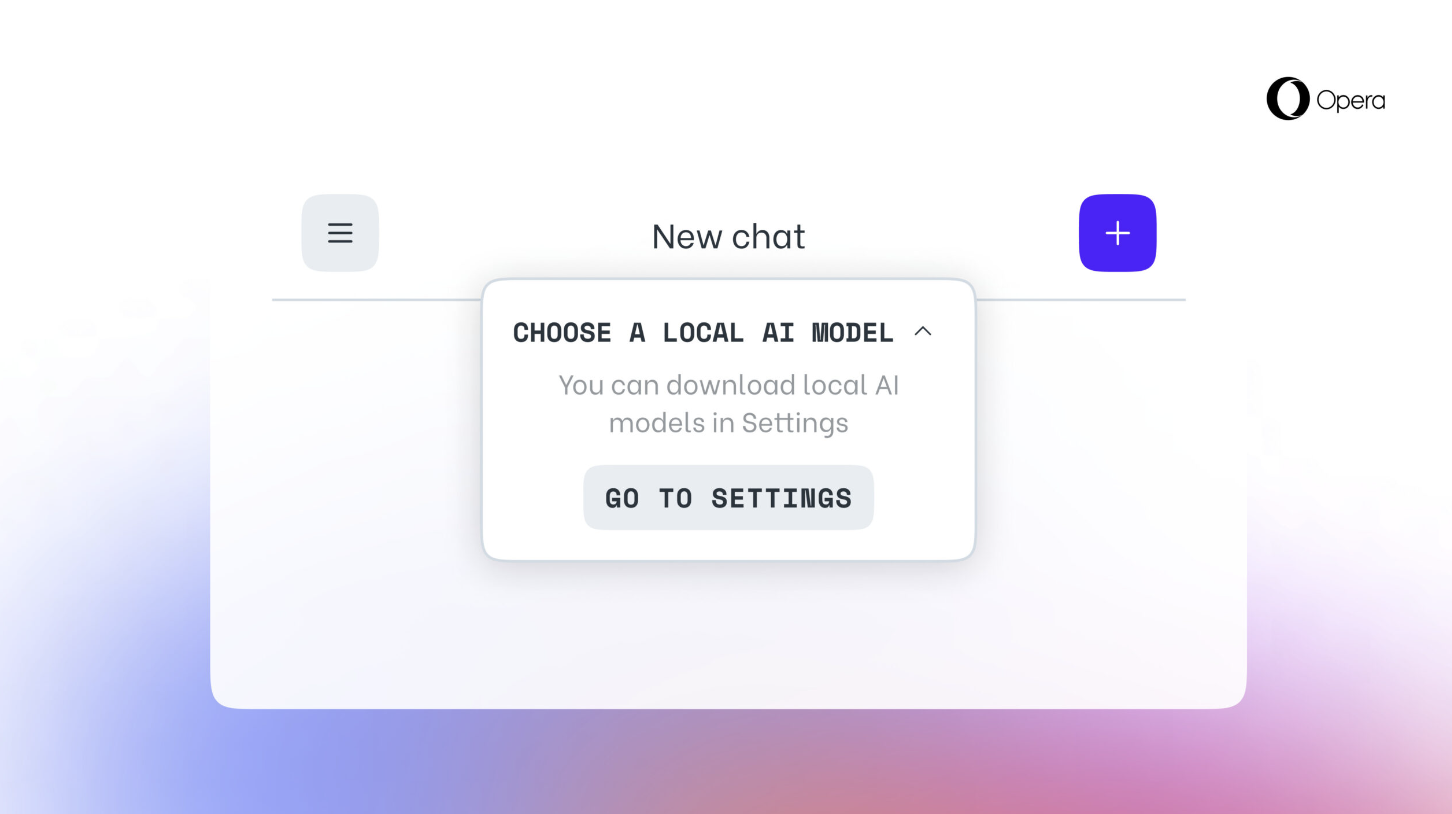

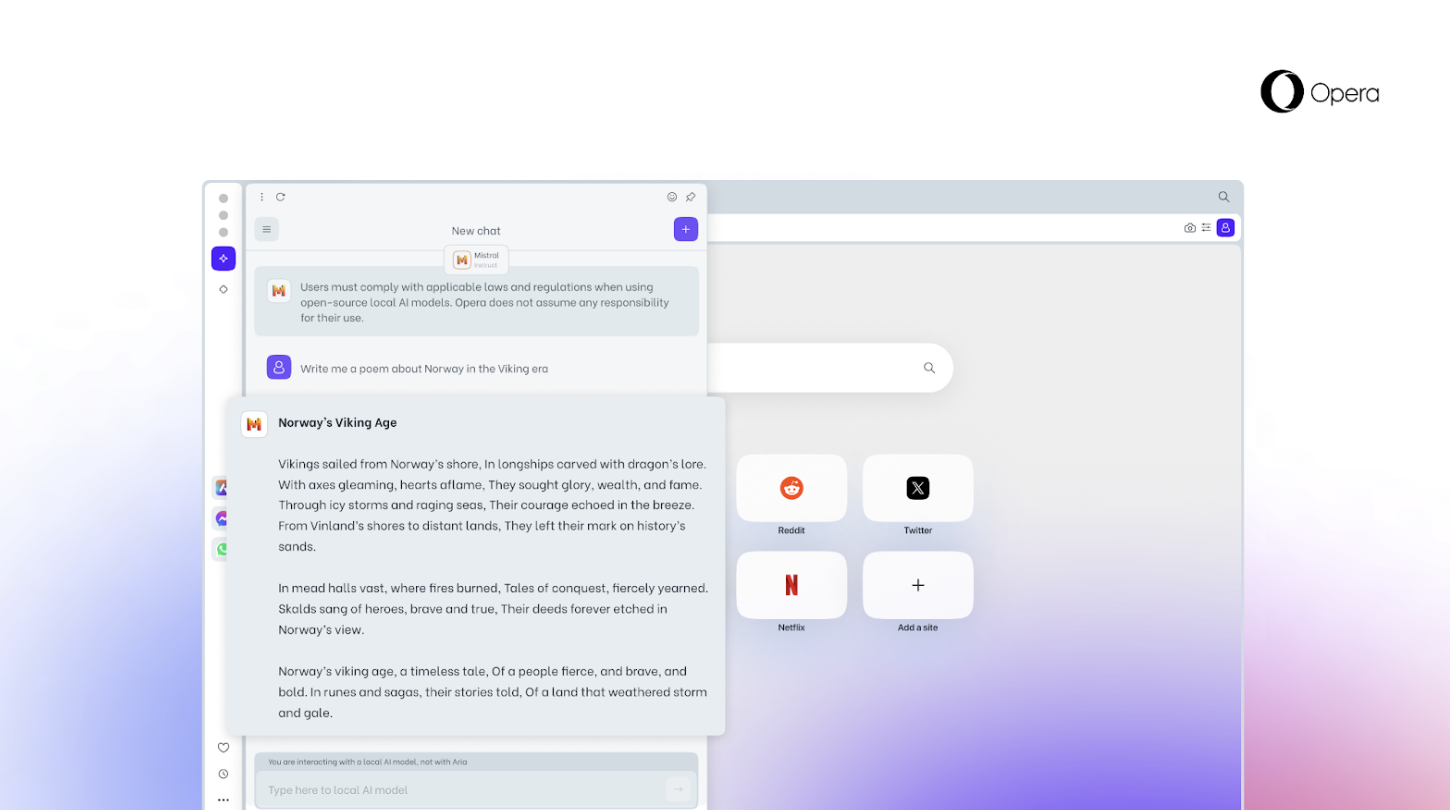

使用本地大型语言模型意味着用户的数据保存在本地设备上,无需将信息发送到服务器。Opera 正在 Opera One 的开发者频道中测试这套新的本地 LLM。本地 LLM 通常需要每个模型 2-10 GB 的本地存储空间,然后将使用本地 LLM 代替 Opera 的 AI Aria。

相关内容