在 WWDC24 之前,苹果在 Hugging Face 平台上发布了一个「具有开源训练和推理框架的高效语言模型」,名为 OpenELM。

官方介绍称:大型语言模型的可重复性和透明性对于推进开放研究、确保结果的可信度以及调查数据和模型偏差以及潜在风险至关重要。为此,我们发布了 OpenELM,一个最先进的开源语言模型。

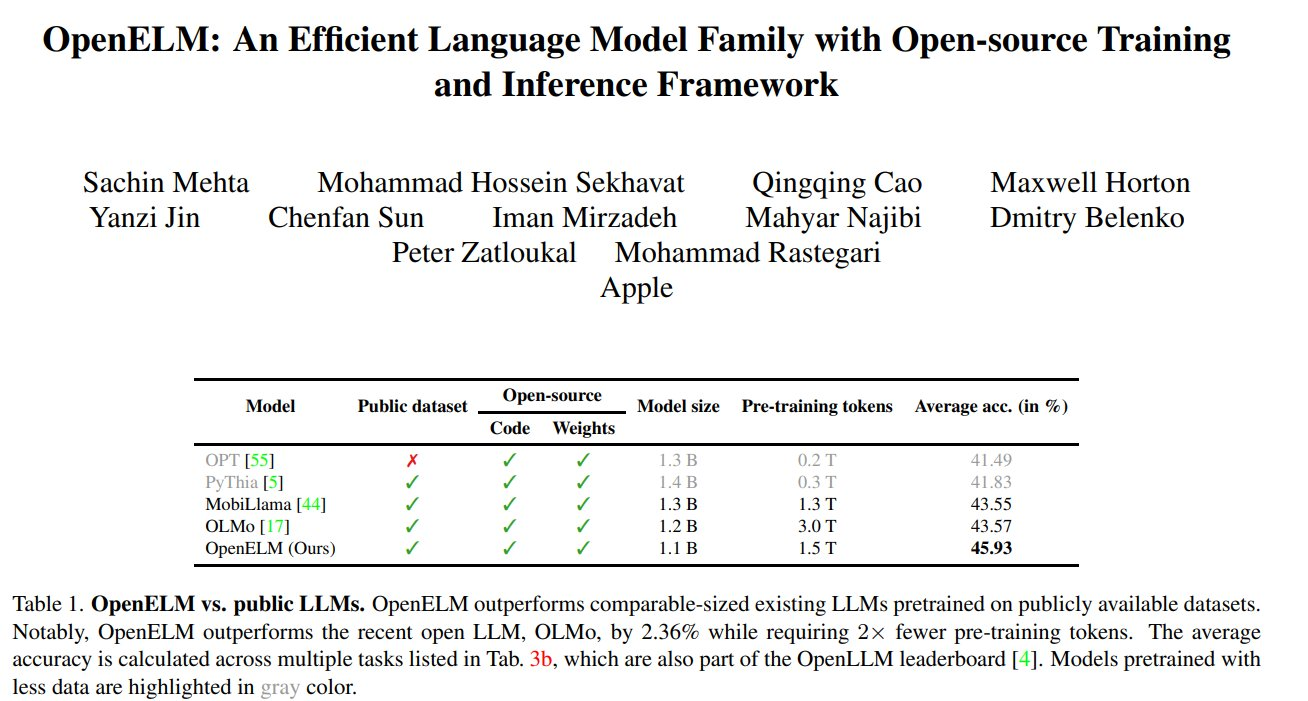

OpenELM 使用分层缩放策略,可以有效地分配 Transformer 模型每一层的参数,从而提高准确率。例如,在参数量约为 10 亿的情况下,OpenELM 与 OLMo 相比准确率提升了 2.36%,同时所需的预训练 tokens 数量仅有原来的 50%。

OpenELM 有四种尺寸:2.7亿、4.5亿、11亿和30亿个参数。而微软Phi-3模型为38亿,因此前者在小型机型上运行成本更低,可在手机和笔记本电脑等移动设备上运行,是做AI硬件的绝佳小模型。

OpenELM 核心特性如下

- 功能:该模型能够执行生成文本、代码、翻译、总结摘要等功能。

- 预训练数据:尽管最小的模型只有2.7亿参数,但苹果使用了1.8万亿tokens的数据进行预训练,这是其小参数下仍能表现出色的原因之一。

- 苹果的开源策略:苹果通常在手机领域采取闭源策略,但此次开源可能是为了吸引用户,未来可能会推出闭源产品实现商业化。

- 技术贡献:苹果不仅发布了模型权重和推理代码,还发布了完整的训练和评估框架,包括数据准备、模型训练、微调和评估流程,以及多个预训练检查点和训练日志。

- OpenELM架构:OpenELM的架构,包括其技术创新点,如无编码器的transformer架构、层级缩放策略、不使用全连接层中的可学习偏置参数等。

- 训练流程与数据集:苹果使用CoreNet作为训练框架,Adam优化算法,以及动态分词和数据过滤的方法。

论文地址:https://arxiv.org/abs/2404.14619

模型地址:https://huggingface.co/apple/OpenELM