Ollama目前可以macOS,Linux和Windows端运行

以Windows端为例

我们首先进入官网:https://www.ollama.com

点击Download

继续选择Download for Windows

双击安装程序,点击Install进行安装

安装完成后没有提示,我们打开cmd或者WindowsPowerShell,输入ollama

显示如下内容,则安装成功

安装成功后我们需要下载使用的模型,可以在https://ollama.com/library搜索,这里有很多主流的模型:

以phi3为例,我们点击即可看到模型的介绍及安装方法

左边可以选择安装的模型大小,对于phi3这个轻量级模型,我们选择默认的latest即可,然后复制右边的运行命令到cmd终端运行:(先别着急运行)

因为Ollama默认的安装路径是在C:\Users\username\.ollama\models,如果要更改安装路径,我们可以使用OLLAMA_MODELS进行修改:

你可以在其它磁盘新建一个文件夹,比如叫OllamaCache,然后在终端输入:

OLLAMA_MODELS:F:\OllamaCache

在修改安装路径的同时,我们还需要配置系统的环境变量,打开环境变量,在下方点击新建:

变量名为:OLLAMA_MODELS

变量值为:你的存放模型的位置(F:\OllamaCache)

完成之后一步一步点击确定,退出

然后在终端重新输入安装命令:ollama run phi3,等待安装完成,下载的可能有点慢,安装完成后显示success,就可以聊天了

随便输入一个问题测试一下:

可以看到对于phi3这个轻量模型,本地运行的速度很快

至此,在Window端部署Ollama并运行大模型就已经完成了一半

在终端使用说到底还是不够易用,不过Ollama也为我们提供了一系列周边工具,比如你可以给它套上一个外壳,像主流的AI工具那样使用WebUI来进行交互

我们可以使用OpenWebUI这个项目:

地址:https://github.com/open-webui/open-webui

这个项目需要以Docker进行部署

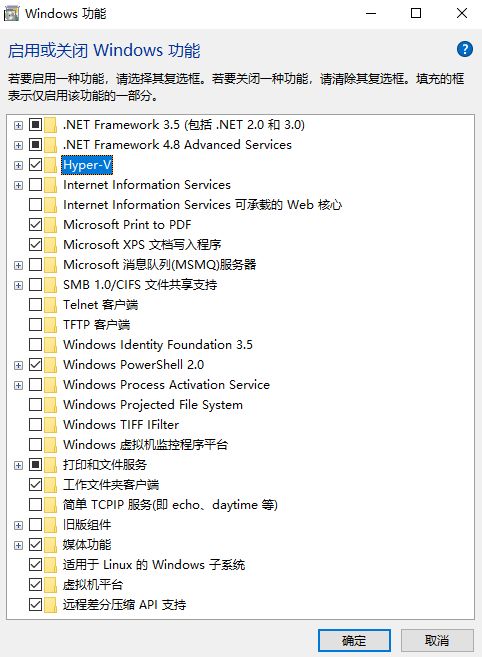

首先确保你已经在Windows功能里面打开了Hyper-V、虚拟机平台和Linux子系统

Windows家庭版没有Hyper-V,安装起来可能有点麻烦,但是我们可能通过系统版本转换将家庭版转换为专业版,然后通过命令去安装Hyper-V(这个后面再出一期)

准备工作完成之后我们就可以去安装Docker了,你可以在官网下载docker的Windows安装包:https://docs.docker.com/desktop/install/windows-install/

默认会下载最新版本,但是如果你的Windows版本较低的话可能会安装失败

所以我们可以点击下面的Release notes

选择一个较低的版本来安装

安装完成后打开桌面上的Docker

在Ollama-WebUI的github页面我们往下滑到How to Install

可以看到,如果你的Ollama和Open WebUI在同一台主机,可以使用下面的这一行命令进行部署:

dockerrun -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -vopen-webui:/app/backend/data --name open-webui --restart alwaysghcr.io/open-webui/open-webui:main

我们打开终端,首先检查Docker是否正常运行

然后将刚才的命令复制过来,等待安装完成即可

安装完成后,在DockerDesktop中会更新这个项目,并且可以看到Open WebUI的地址,也就是我们本地的3000端口

直接点击,会打开浏览器页面:

我们点击下面的创建账号,创建好之后登录,进入OpenWebUI的主界面:

点击左下角头像,可以将界面的语言设置为中文,也可以在此处配置和管理你的模型

返回主界面,在上方会列出所有你安装的模型,可以进行选择

我们随机选择一个进行测试

可以看到这个模型已经跑起来了

至此,在Window端部署Ollama并运行大模型就已经完成了

当然,Ollama还有很多神奇的玩法,比如你可以把从HuggingFace上下载的模型文件拿来跑

理论上Ollama可以本地运行任何模型

安装过程中如果遇到什么问题可以留言,看到就会回复