苹果借由于旗下macOS Sequoia、iOS 18与iPadOS 18作业系统中整合Apple Intelligence,加入了全球的人工智慧(AI)阵营,Apple Intelligence是由许多高效能生成式模型所组织,本周苹果揭露了其中的两个,一个是装置上的小型语言模型,另一个是伺服器上的较大型语言模型。

其中,在装置运作的语言模型不到30亿个参数,另一个较大的语言模型则是透过Private Cloud Compute于基于苹果晶片的伺服器上执行。苹果利用取得授权的资料,以及透过AppleBot搜集的公开资料来训练基础模型,某些授权资料可用来强化特定功能,此外,苹果亦强调不使用个人资料进行训练,也会过滤低品质的内容。

装置与伺服器上的模型皆使用分组查询注意(grouped-query-attention)机制,以优化注意力机制并提高模型效率,并有共享的输入与输出词汇嵌入表,以降低记忆体需求及推论成本。装置端模型的Token数量为49K,伺服器端模型的Token数量则是100K。

苹果借由low-bit palletization与Low-Rank Adaptation(LoRA)微调技术,来减少装置模型在推论时所需的资源,同时维持其准确性,也透过Talaria工具、激化量化、嵌入量化,以及关键值快取更新等方法来提升模型运作效率,因此,在 iPhone 15 Pro上,模型收到提示后生成第一个Token的时间只要0.6毫秒,平均每秒可生成30个Token。

在预训练的模型上,苹果利用微调层来迎合使用者的日常活动,将小型神经模组(微调器)插入模型中,以改善模型对特定任务的执行能力。苹果比较了自家装置模型+微调器、与微软Phi-3-mini在摘录上的能力,发现不管是在电子邮件或是通知的摘录上,人类对苹果模型的摘录结果都更为满意。

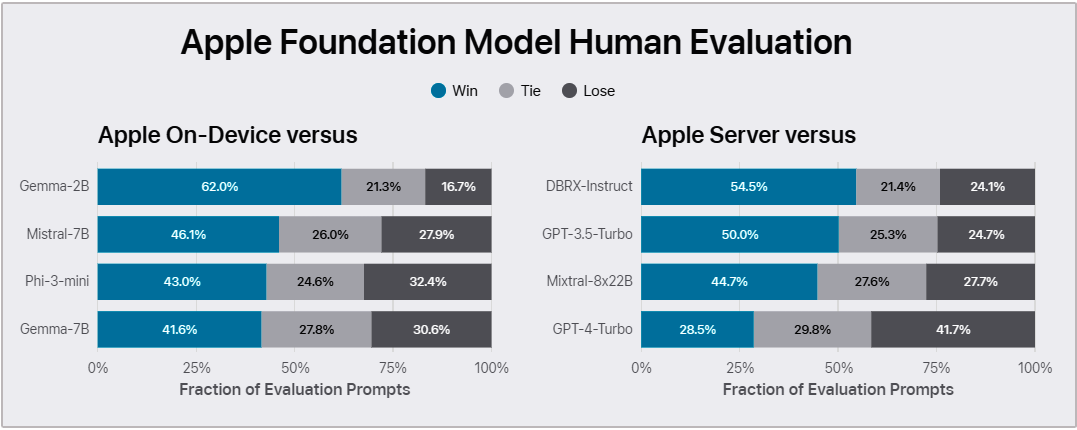

另外苹果也比较这两个模型与开源的Phi-3、Gemma、Mistral、DBRX及商用的GPT-3.5-Turbo及GPT-4-Turbo,显示不管是在装置模型或伺服器模型上,苹果多半更受到人类评估人员的青睐,只有伺服器模型明显落后GPT-4-Turbo。且不管是在输出危害、安全提示、指令追踪能力或是写作能力上,两个苹果模型也都有不亚于其它竞争对手的表现。

除了这两个分别位于装置及伺服器上的基础模型之外,之后苹果亦会陆续揭露该公司所使用的其它生成式模型,包括语言、扩散与程式码模型等。

图片来源/苹果

.png)