来自Meta、艾伦AI研究院和华盛顿大学的研究团队开源一款语言模型代理哈士奇(HUSKY),可处理复杂的多步骤推理任务,透过2个阶段不断迭代。

重点新闻(0619~0625)

Husky-v1 语言模型 代理

Meta开源一款AI代理「哈士奇」

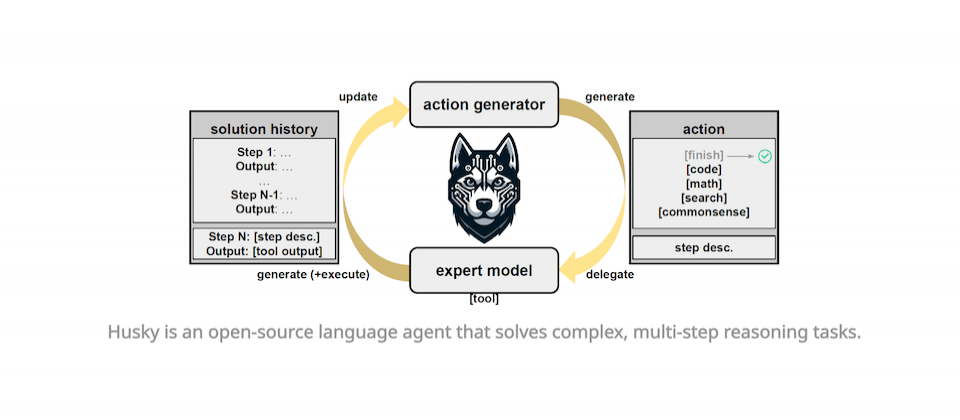

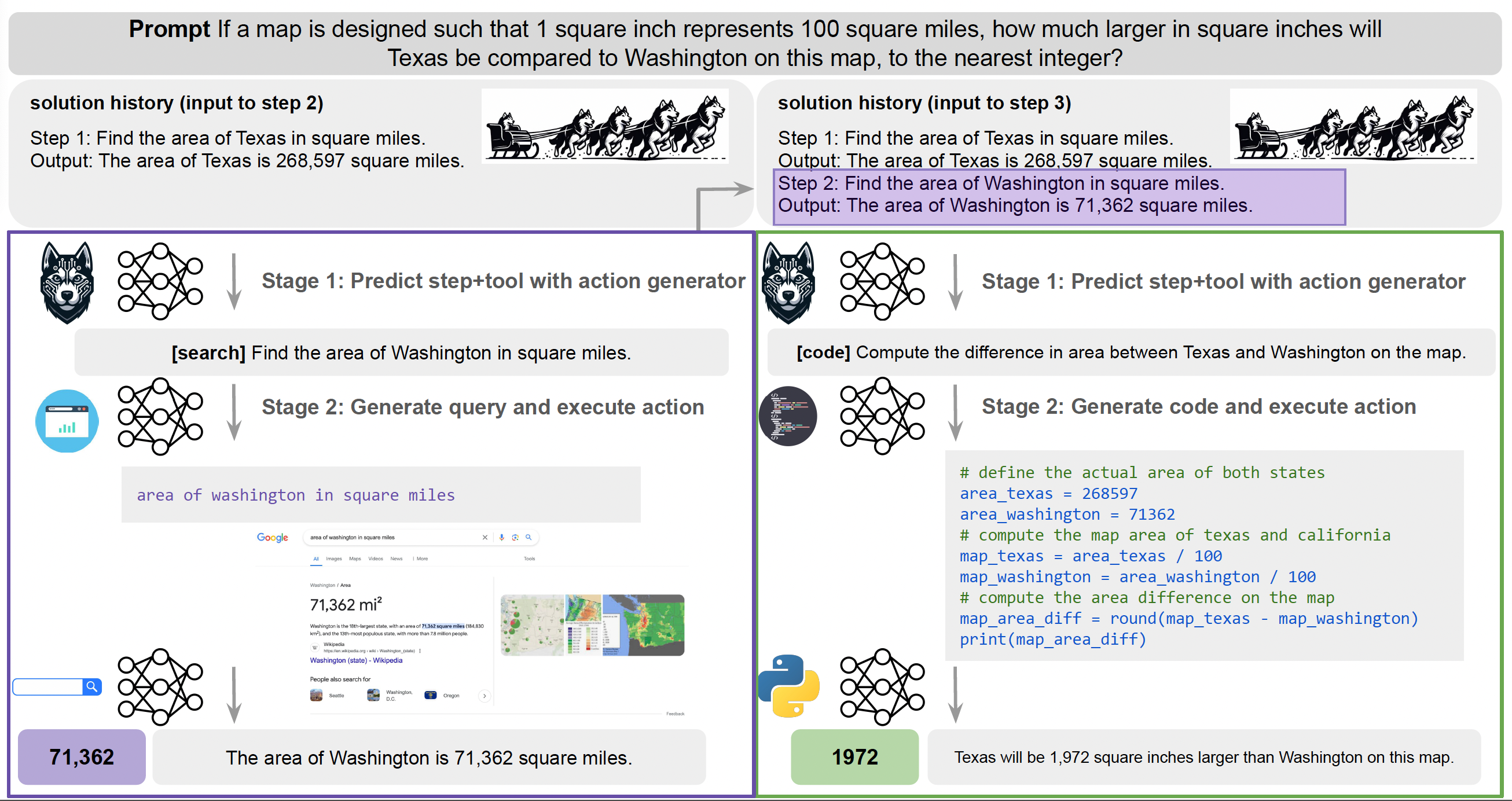

最近,来自Meta、艾伦AI研究院和华盛顿大学的研究团队开源一款语言模型代理哈士奇(HUSKY),可处理复杂的多步骤推理任务。进一步来说,AI代理(Agent)是指由AI模型驱动的智慧系统,可从环境中学习、适应并自动完成特定任务,比如Siri。而哈士奇这个代理在统一空间中执行运算,意味著单一个哈士奇就能处理多类型任务,像是数值、表格和知识推理,而非只专注特定任务,如程式码撰写代理。

团队发表的第一代哈士奇代理为Husky-v1,透过2个阶段不断迭代:首先是根据给定任务,来生成下一步的解决动作,再来是用专家模型执行这个动作,同时不断更新解决方案。其中,第一代哈士奇的专家模型包含程式码生成器、询问生成器和数学推理器等3款,它们皆用合成资料训练而成。团队也用14个不同任务来评测Husky-v1,发现它的表现优于其他代理,如CoT、ReAct、Lumos等,甚至在混合工具推理任务中,胜过GPT-4-Turbo。(详全文)

苹果 LLM MLX

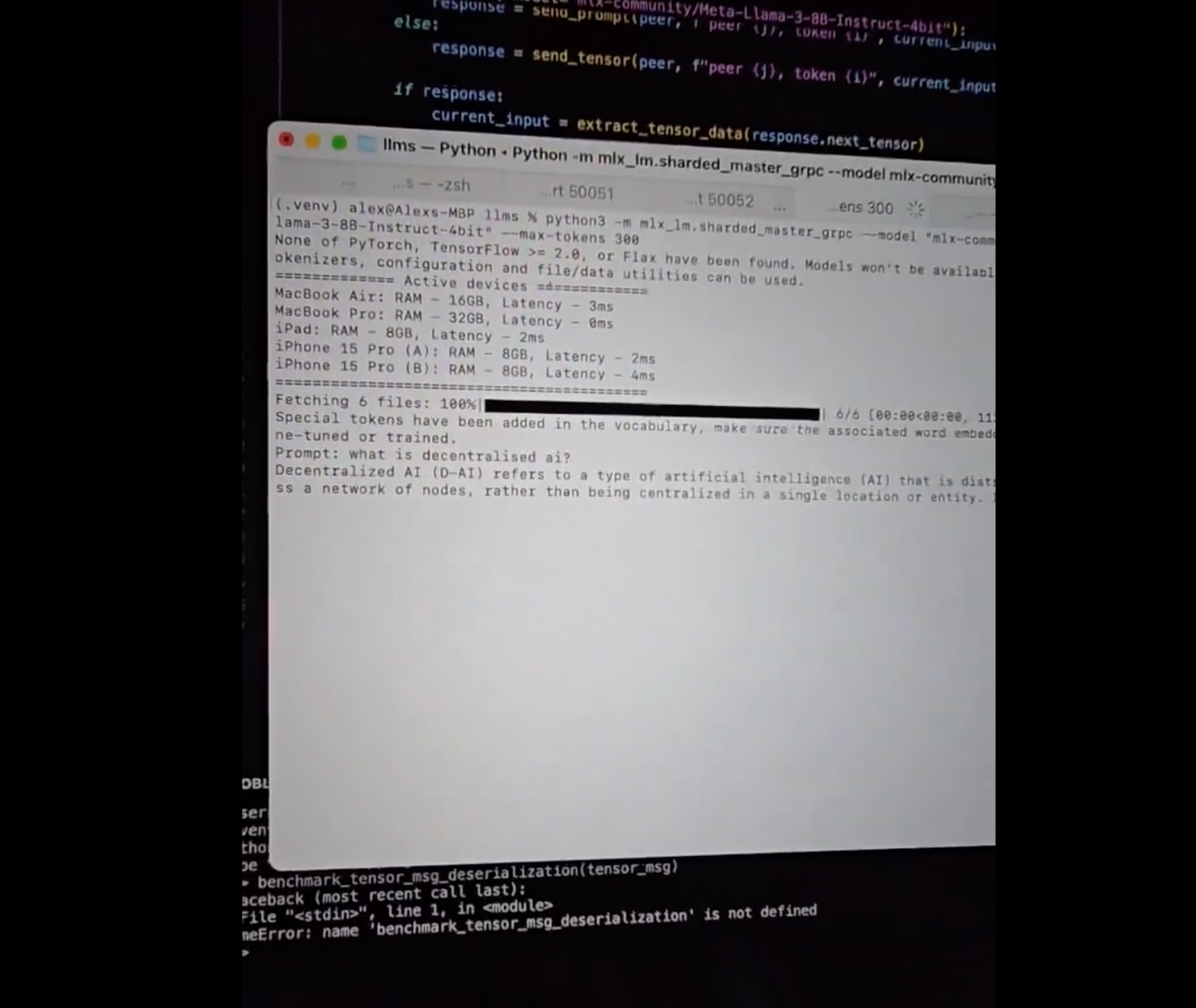

开发者可用MLX函式库,联合多台苹果装置跑大模型了

最近,苹果才结束今年度发表大会WWDC,主打Apple Intelligence、聚焦个人化AI功能和隐私保护,但还留了一手。也就是,开发者可用苹果的开源机器学习函式库MLX,来联合苹果装置(如Mac笔电、iPhone手机和iPad等)算力、形成一个AI丛集,来执行大型AI模型。

日前就有位开发者Mohamed Baioumy分享经验,他使用了2台MacBook、2支iPhone 15 Pro和1台iPad,来执行80亿参数的Llama 3 instruct 4 bit模型,可以非常快的速度回答文字问题。另有位开发者Mohamed Baioumy表示,就算不是苹果装置也可以,也就是说,只要所有装置都使用同一个网路,开发者就可堆叠多个装置来跑大模型。这代表,开发者可透过多个装置来执行先进的AI模型了。(详全文)

金管会 AI指引 金融业

金管会发布金融业运用AI指引

最近,金管会终于发布「金融业运用AI指引」,与去年12月底提出的草案大方向一致,除提供AI系统和生成式AI定义,也说明4个AI系统生命周期阶段,并提供业者在各阶段中落实6大核心原则的处理机制。

进一步来说,这份AI指引就像是一份AI操作建议书,分别引导业者在导入AI或使用生成式AI时,如何在4个阶段中,包括系统规画及设计、资料搜集及输入、模型建立及验证、系统部署及监控等阶段,落实6大核心原则,也就是建立治理及问责机制、重视公平性及以人为本的价值观、保护隐私及客户权益、确保系统稳健性与安全性、落实透明性与可解释性,和促进永续发展。

比起草案,这份正式版多出了实务作法,也提及更多第三方业者的监督管理方式,对自建、委外和外购等不同部署方式增订相关内容,也修改风险评估因素的叙述方式、增加指引适用的弹性。综合规画处处长胡则华指出,目前采用生成式AI的金融机构有29家,银行业占最多,使用场景大多为内部作业,第二是智能客服,第三则是行销广告。(详全文)

语言模型 Meta 程式撰写

Meta揭露4款语言模型,涵盖程式撰写、音乐生成和音讯浮水印

日前,Meta AI研究院最近发表4款语言模型,包括Meta Chameleon,含70亿参数(7B)和340亿参数(34B)版本,支援多模态输入值,但只以文字输出。另一款模型是Meta Multi-Token Prediction,是一款预训练语言模型,专门用来处理程式码撰写任务。这是因为该模型采用多Token预测方法,可即时预测好几个字,而非只预测一个,也因此提高了作业效率和回应速度。

第三款模型是Meta JASCO,是一款生成式文字转音乐模型,预计晚些时候释出预训练模型。最后一个模型是Meta AudioSeal,是一款音讯浮水印模型,能在装置端侦测AI生成的语音,并配上浮水印;该模型开放商用授权。除了模型,Meta也发表负责任AI研究成果,包括了研究本身、资料和程式码,可用来衡量和改善AI系统中的地理表征、文化偏好和多元性。(详全文)

Luma AI 影片生成 Dream Machine

美AI新创开源高品质影片生成模型

旧金山一家AI新创Luma AI最近发表AI系统Dream Machine,可根据简单的文字描述,来生成高品质影片,且号称几分钟就能完成。有别于OpenAI的影片生成模型Sora和快手的Kling、只对特定群众开放,Luma AI开放各界免费在自家网站尝试这款系统。

Luma AI表示,Dream Machine目前虽只能生成5秒长的影片,但在品质上相对写实逼真,可应用的领域更广。(详全文)

Claude 3.5 Sonnet Anthropic 语言模型

Claude 3.5 Sonnet问世了,评测表现胜过GPT-4o

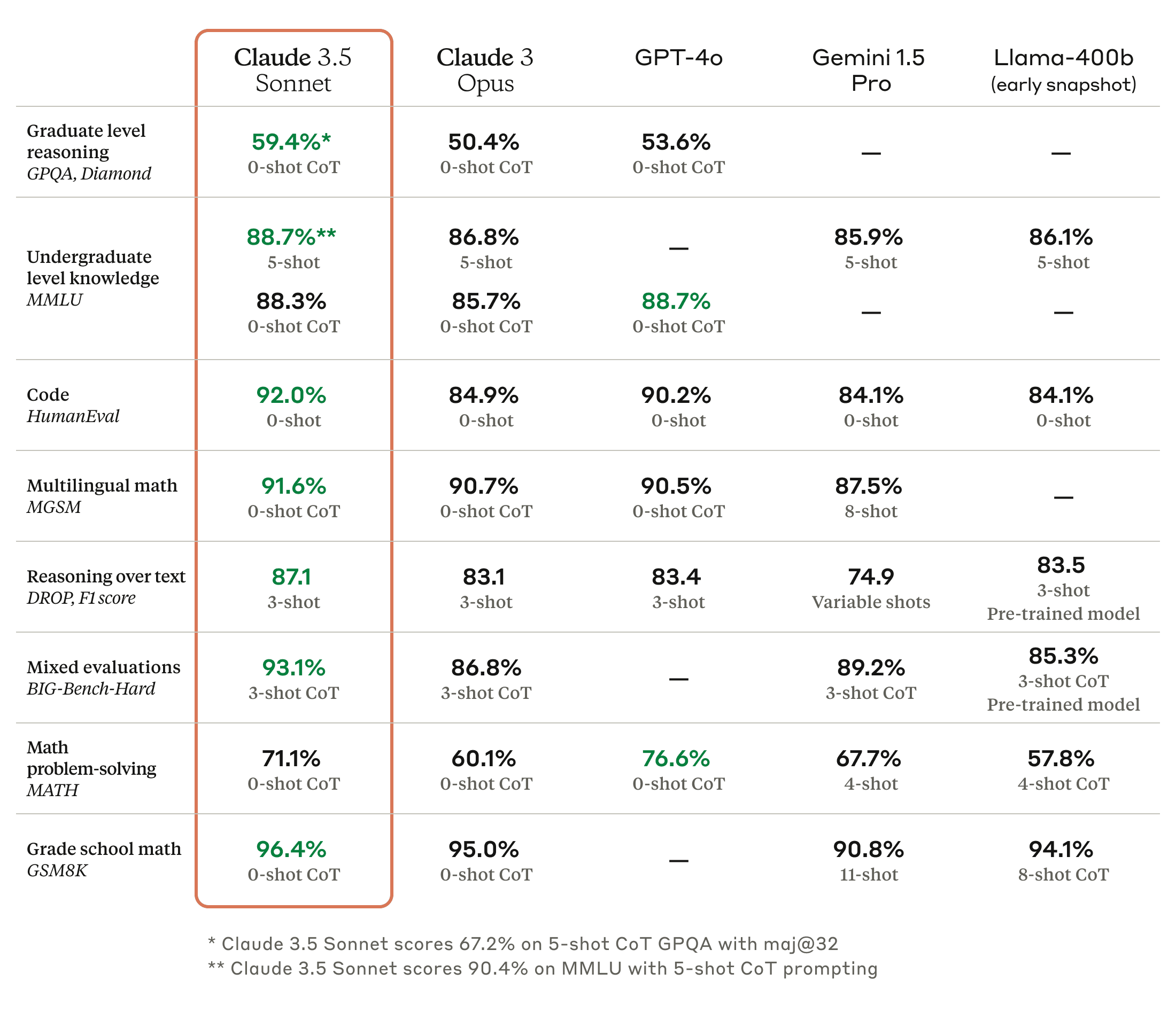

Anthropic日前发表了新款大型语言模型Claude 3.5 Sonnet,是Claude系列的中阶模型,但表现和效率都超越Claude 3.0的高阶模型Opus,在大多数的评测上也胜过OpenAI今年5月推出的GPT-4o。进一步来说,Claude 3.5 Sonnet的执行速度是Claude 3 Opus的两倍,Anthropic自己也以自然语言指令,要求不同模型修补开源程式码臭虫或新增功能,发现Claude 3.5 Sonnet解决了64%的问题,超越Claude 3 Opus的38%。

在提供指示与相关工具后,Claude 3.5 Sonnet得以独立撰写、编辑与执行程式码,可执行复杂的推论及故障排除能力,轻松处理程式码的转换,能更有效率更新老旧应用程式并迁移程式码库。Claude 3.5 Sonnet不仅在所有基准评测上胜过Claude 3 Opus,它在GPQA、HumanEval、MGSM、DROP、BIG-Bench-Hard或是与视觉有关的MathVista、AI2D、Relaxed accuracy及ANLS score等评测上也超越了GPT-4o,只有在MMLU、MATH及MMMU上略逊GPT-4o。(详全文)

EVI Hume AI 情绪辨识

Hume AI推出懂53种情绪的iOS App:EVI

最近,Hume AI上架一款号称读懂人类情绪的iOS应用程式EVI,由Anthropic最新的语言模型Claude 3.5 Sonnet驱动。特别的是,EVI背后的同理心大语言模型可解读语调、强调字眼和非口语的暗示,来优化互动体验。EVI可理解53种人类情绪,如开心、生气、困惑、欺骗等。至于EVI采用的声音模型Kora,则能以API方式提供给开发者,目前也支援Anthropic、OpenAI和开源语言模型,预计之后很快就会纳入Google模型。开发者可以建立他们的应用程式,并加入EVI的Discord来获得更新资讯。

EVI的情绪理解能力,是来自Hume AI对非话语的情绪性语音研究成果,这类语音是指透露情绪的语助词,或单纯是透露情绪的发声词。为训练EVI的情绪理解模型,Hume AI收集了来自1万6千多人共数千个语音片段档案,横跨美国、中国、印度、南非和委内瑞拉。Hume AI表示,未来,他们打算扩展EVI能力,增添全球通用的脸部表情辨识能力。(详全文)

Databricks AI治理 Unity Catalog

Databricks揭露一款资料与AI治理工具,采开放API和通用介面

Databricks最近宣布,将于今年第3季发表一款统一、可跨云和资料平台的资料与AI治理解决方案Unity Catalog OSS预览版。Databricks希望藉该工具,来建立AI治理可互通的开放标准。

这款Unity Catalog OSS提供通用介面,可支援多种资料各式和运算引擎,还能统一治理表格类资料、非结构化资料、机器学习模型等AI资产。在AI治理部分,这款工具可自动监控模型、诊断错误并维护资料和模型品质。该工具也会主动发出警报、自动侦测个人识别资讯(PII)资料、追踪模型是否漂移,并能解决资料和AI工作流程中的问题。透过开放API和Apache 2.0授权,使用者可免于被厂商绑死,不过,AWS、Google Cloud、微软、Salesforce、Confluent、dbt Labs、Immuta等多家业者都表示支援Unity Catalog OSS,认为此举为使用者带来更大的弹性,还与开源生态系原则相符。(详全文)

图片来源/Meta、Mohamed Baioumy、Luma AI、Anthropic、Hume AI、Databricks

AI近期新闻

2. 前OpenAI首席科学家Ilya Sutskever成立新公司,瞄准AI安全性

3. Pixel 8、Pixel 8a终于也有Gemini Nano了

资料来源:iThome整理,2024年6月