6 月,三笔巨额融资掀开大模型战事新篇章。

前脚,加拿大 Cohere 以 50 亿美元估值揽获 4.5 亿美元融资,英伟达、思科助力;后脚,法国 Mistral AI 喜提 6 亿欧元,General Catalyst 领投;随后,日本 SakanaAI 也传出即将斩获超 1 亿美元融资,估值飚至约 11.5 亿美元。

春江水暖鸭先知,国际 VC 押注各地 AI 独角兽强势出圈背后,一个共性趋势随即浮现:PK OpenAI,他们正以小参数、低成本落地端侧“突围”。

Cohere 开源的新一代大模型 Aya 23,以 80 亿和 350 亿两种参数,支持 23 种语言;Mistral AI 去年发布的 Mistral 7B,以 70 亿参数打败了数百亿参数的开源大语言模型霸主 Llama 2,另一款模型 Mistral Large 开发成本低于 2000 万欧元(约 2200 万美元),对比 GPT-4 的开发成本,更是打掉了超 4/5;再到 Sakana 这边,其以核心的“模型合并”技术来自动化“进化”算法,号称对算力资源的需求极小、能将数据学习周期缩短数百倍。

群雄逐鹿之下,这场 AI 盛宴行至 2024,已然不再是一场堆算力、垒数据的“烧钱”游戏。

寻找 Transformer 外的可能,

“天选”端模来了

身处大模型一线,近半年,刘凡平对底层技术架构的创新和突破这一趋势有着明显的直接感受。

“在全球范围内,一直以来都有不少优秀的研究者试图从根本上解决对 Transformer 架构的过度依赖,寻求更优的办法替代 Transformer。就连 Transformer 的论文作者之一 Llion Jones 也在探索‘Transformer 之后的可能’,试图用一种基于进化原理的自然启发智能方法,从不同角度创造对 AI 框架的再定义。”

他看到,技术变化永远走在最前面,需要时时刻刻保持“不被颠覆”的警惕,但一方面,这个 80 后创业者看到新技术带来新产品、新市场机遇的出现,又对行业利好倍感兴奋。

在这场对标 OpenAI 的竞赛中,刘凡平也早就做好了准备,其带队的 RockAI 亦走出了一条属于自己的进化路径。

自成立伊始,RockAI 就不曾是 Transformer 学徒,即便是在“百模大战”打得火热的去年,刘凡平就意识到 Transformer 架构底层设计逻辑对训练数据量的要求极大,虽是大模型的智能体现,却难以避免“一本正经的胡说八道”的幻觉问题,包括训练的资源消耗已成行业通病。

甚至连 Transformer 这个架构的设计者 Aidan Gomez,都对“做了很多浪费的计算”一声叹息,希望“Transformer 能被某种东西所取代,将人类带到一个新的性能高原。”

可谓,成也萧何败也萧何。

但更大的挑战在于,Transformer 在实际应用中的高算力和高成本,让不少中小型企业望而却步。其内部架构的复杂性,让决策过程难以解释;长序列处理困难和无法控制的幻觉问题也限制了大模型在某些关键领域和特殊场景的广泛应用。

在行业对于高效能、低能耗 AI 大模型的需求不断增长下,彼时,刘凡平就一直在思考“大模型动辄上万亿的 token 训练是否真的必要”,对 Transformer 模型不断的调研和改进过程中,更让他意识到了重新设计大模型的必要性。

以人类大脑几十亿的训练量来看,他判断,数据、算力并不是最终的瓶颈,架构、算法才是重要的影响因素,就此开启了 RockAI“破坏式”自研突围。

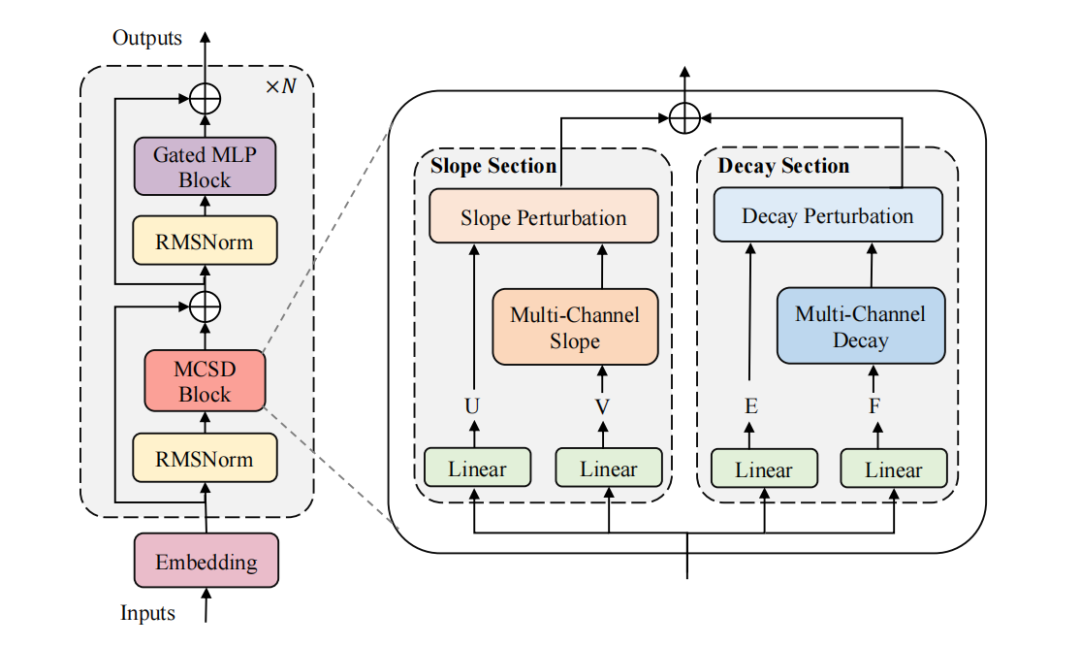

1 月,刘凡平带着国内首个非 Attention 机制的通用自然语言大模型——Yan1.0 模型公开露面。

当时,1.0 版通过对 Attention 的替换,将计算复杂度降为线性,大幅降低了对算力的需求,用百亿级参数达成千亿参数大模型的性能效果——记忆能力提升 3 倍、训练效率提升 7 倍的同时,实现推理吞吐量的 5 倍提升。

更令人欣喜的是现场,Yan 1.0 模型在个人电脑端的运行推理展示,证实了其可以“原生无损”在主流消费级 CPU 等端侧设备上运行的实操性。

要知道,原生无损对应的反面就是有损压缩,后者是目前大模型部署到设备端的主流方式。

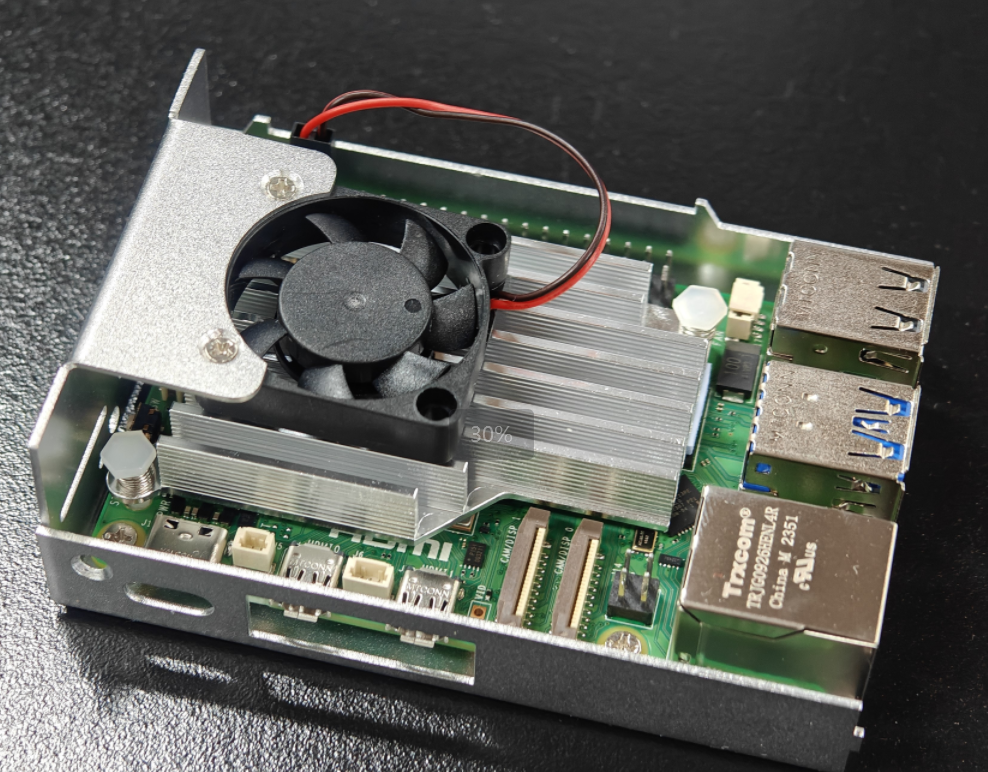

大热的 AIPC 是把 Transformer 架构的模型通过量化压缩部署到了个人电脑,甚至 70 亿参数的大模型还需要定制的 PC 芯片提供算力;就连 Llama3 8B 以每秒 1.89 个 token 的速度运行树莓派 5,支持 8K 上下文窗口的战绩,也是止步于“有损压缩”。

更大的模型效果更好,但是如果不通过量化压缩是部署不到个人设备上的,恰好说明了 Scaling law 的局限。

同时,有损压缩如同把平铺的纸揉小后有褶皱般放入,让多模态下的性能损失无法恢复到原有状态去进行模型训练,更直接导致卡住不动、死机等不确定问题的出现,甚至三五分钟才能蹦完一句话。

“去”量化压缩这一步意味着 Yan 模型在设备端运行避开了多模态下的性能损失,以及具备再学习的能力,也就是说在兼容更多低算力设备上,是“天选级”端侧模型。

同步学习,让模型边跑边进化

“原生无损”部署到个人电脑,这只是 Yan 1.0 的表现。

刘凡平还有 2 个疑问待解,一是能不能在更低算力、更普适的设备上部署大模型;二是部署在端侧以后,模型能不能个性化的即时学习。

而这两个问题的实现,直接带着 RockAI 朝着 Yan 2.0 进发。

看到 AIPC 依然是云端大模型为主,离线状态下模型基本只勉强可用,而用户的个人隐私在云端模式下依然待解,刘凡平意识到要找到更低算力且可大部分时间离线使用的设备来做进入设备的“敲门砖”。

“PC 或者高端手机其实模型量化都能跑,但是高端设备的 GPU 算力跟低端设备差距很大,所以 PK 得往更低端设备走,才能跟设备厂商获得谈的资格。”

于是,他的目光便落到了树莓派上。

这个袖珍型小巧却又性能强大的微型电脑,可广泛应用于物联网、工业自动化、智慧农业、新能源、智能家居等场景及设备,譬如门禁、机器人等终端,同时,大部分情况没有联网。

这就意味着,跑通树莓派,等同于打开了低算力设备端的大门以及不联网的多场景应用。

为了“拿下”树莓派,刘凡平得进一步实现 Yan 模型的降本增效,于是在算法侧,基于仿生神经元驱动的选择算法便出现在了眼下的 Yan 1.2 模型上。

参考人脑的神经元大概是 800-1000 亿,功耗大概是 20-30 瓦,而一台 GPU 算力服务器功耗能到 2000 瓦,刘凡平认为主流大模型的全参数激活,本身就是不必要的大功耗浪费。

而基于仿生神经元驱动的选择算法,便是使大模型可以根据学习的类型和知识的范围分区激活,如同人开车跟写字会分别激活脑部的视觉区域和阅读区域一般,不仅可以减少数据训练量,同时也能有效发挥多模态的潜力。

据悉,在 3 月类脑分区激活的工作机制实现后,甚至 10 亿级参数的 Yan 模型通过改进在 0 压缩和 0 裁剪的情况下在一台 7 年前生产的 Mac 笔记本的 CPU 上跑通本地训练过程,5 月 Yan 1.2 模型便成功跑通树莓派。

值得注意的是,模型分区激活不仅可以降低功耗,同时还能实现部分更新,也就意味着部署后还具备持续学习能力,而这又是 Transformer 一众学徒的“软肋”。

众所周知,大模型的出现也带来一种开发范式:先通过预训练让大模型具备一定的基本能力,然后在下游任务中通过微调对齐,激发模型举一反三的能力。

这就类似先花大量的时间和资源把 1 岁孩子封闭式培养到成为大学生,然后在不同的工作场景里进行锻炼对齐。

这种范式统一了以往处理不同自然语言任务需要训练不同模型的问题,但也限制了模型在不同场景的应用。

如果换一个没有经过预训练的工作场景,一切都要从头再来,两个字概括:麻烦。

一个离自主进化遥远的 Transformer 大模型,反映到现有实践中,那就是一旦内容变化,往往要 1-2 个月去把数据清掉后,再重新训练后进行提交。

预训练完之后再大规模反向更新,无论从算力、时间还是经济成本,对企业而言“难以接受”,也让刘凡平在低消耗、显存受限的情况下,为实现端侧训推同步,在模型分区可部分激活更新下,持续寻找反向传播的更优解,试验能更低代价更新神经网络的方案。

从反向传播对参数的调节过程来看,只要模型调整足够快、代价足够小,就能更快达到预期,实现从感知到认知再到决策这一循环的加速,对现有知识体系进行快速更新。

如此一来,通过模型分区激活 + 寻找反向传播更优解“两步走”,就能实现模型的边跑边进化,“同步学习”的概念在 RockAI 逐步清晰。

寻找设备端的智能,谁能成为具身“大脑”?

如上,把一个训练完的 Transformer 大模型比作大学生,那么,一个可同步学习的 Yan 模型,在刘凡平看来,就是一个正在咿呀学语的孩子。

“从小在各种环境下学习,建立知识体系,又不断推翻重建,每一天都有新的体悟,会成独有的知识体系,最终个体多样性会带来群体智慧和分工协作。”

而这样个性化的端侧模型有多重要呢?可以设想:在一个智能城市中,每个家庭的智能家居系统都具备了 Yan 模型这样的能力。这些系统可以根据每个家庭成员的习惯、喜好以及环境变化进行自主学习,并做出相应的调整,个性化服务身边的每一个人。

在刘凡平的设想中,智能“大脑”,关键在于实现模型在边缘计算中的持续学习能力和适应能力。具备同步学习能力的 Yan 2.0 模型部署到手机、电脑,甚至电视、音响等各类设备后,会根据你说的话和场景进行自主学习,判断出你喜欢的事情,通过跟用户对齐,越来越具备个性化价值,最终形成可交互的多样性智能生态。

不过,刘凡平也坦言,相较于 B 端,目前设备端依然是大模型的蓝海市场,离终极的个性化 AI 还差一步。

但这,也给了具备低成本低算力基因的 RockAI,从“为设备而生”到“为设备而用”抢占先机的可能。

Yan2.0 会在年底或明年初面世, 在他看来,这些设备前期的适配工作做足至关重要,现阶段是系统适配各种硬件,端侧模型需要结合实际载体(即硬件)去做适配研究和迭代改进。

在树莓派跑通后,很多机器人厂商也找到了刘凡平,从某种意义上来说,他们也在寻找具身大脑的可能,一家教育机器人公司甚至给到了刘凡平“愿意第一时间集成 Yan 2.0”的回复。

对于具身智能这一爆火命题,刘凡平很坦率,从身到脑都需要搅局者,但他也有“野心”,去成为那个破局人:在技术创新、商业化同步发力。

四个月前,在 Yan 架构的发布会上,他曾提出了打造“全模态实时人机交互系统”的理念,期望 Yan 模型未来向全模态、实时人机交互、训推同步的方向持续升级,使 AI 技术更加易于获取和使用,推动普惠人工智能的发展。

而如今,随着 Yan 2.0 将逐步把多模态的视觉、触觉和听觉能力补齐,并结合同步学习的能力,一个在感知、认知、决策、行动四个方面得到全面提升的机器人似乎也在具象化。

可以预见:在感知方面更多模态输入后,机器人同时拥有眼睛和耳朵,可以实时看到和听到信息,然后把接受到的信息进行认知理解,随着理解加深,能做出对应的有倾向性的、个性化的判断,并支配四肢行动。

一个大模型在更加便携的设备或终端中进行无损部署的蓝图,正在徐徐展开。