人工智能(AI)设计的蛋白质能否被用作生物武器?

为了避免这种可能性——以及避免繁重的政府监管前景——研究人员今天发起了一项倡议,呼吁安全、合乎伦理地使用蛋白质设计。

“在目前这个阶段,蛋白质设计[AI]的潜在益处远远超过了危险,”华盛顿大学西雅图分校的计算生物物理学家大卫·贝克说,他是这项自愿性倡议的一部分。其他几十位将AI应用于生物设计的科学家也签署了该倡议的承诺清单。

Could AI-designed proteins be weaponized? Scientists lay out safety guidelines (nature.com)

“这是一个良好的开端。我会签署它,”乔治敦大学全球健康政策专家马克·迪布尔说,他领导了洛杉矶加州智库海伦娜2023年关于AI和生物安全的一份报告。但他还认为,“我们需要政府的行动和规则,而不仅仅是自愿指导。”

这项倡议是在美国国会、智库和其他组织探索AI工具的可能性之后提出的——这些工具从蛋白质结构预测网络如AlphaFold到支持ChatGPT的大型语言模型等——可能使开发生物武器变得更容易,包括新的毒素或高度传染性病毒。

设计师蛋白质的危险

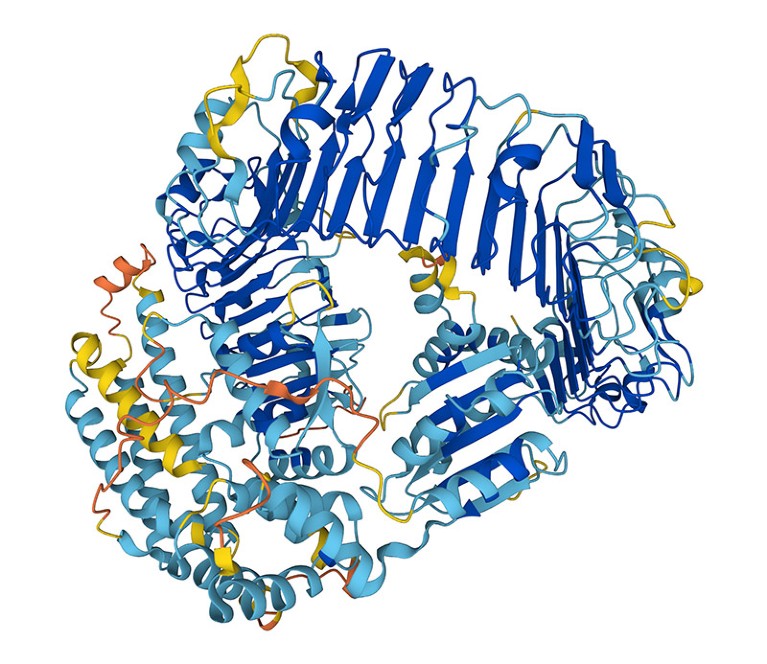

包括贝克和他的同事们在内的研究人员,几十年来一直试图设计和制造新的蛋白质。但是,由于AI的进步,他们这样做的能力近年来得到了爆炸性的增长。曾经需要数年时间或不可能完成的任务——例如设计一个与特定分子结合的蛋白质——现在可以在几分钟内实现。科学家们开发的大多数AI工具都是免费提供的。

为了评估设计师蛋白质被恶意使用的潜在风险,贝克所在的华盛顿大学蛋白质设计研究所在2023年10月举办了一个AI安全峰会。“问题是:蛋白质设计应该如何被监管,如果有的话,有哪些危险?”贝克说。

他和来自美国、欧洲和亚洲的其他几十位科学家今天正在推出的倡议呼吁生物设计社区自我监管。这包括定期审查AI工具的能力并监控研究实践。贝克希望看到他的领域建立一个专家委员会,在软件被广泛提供之前进行审查,并在必要时推荐‘防护措施’。

该倡议还呼吁改进DNA合成的筛选,这是将AI设计的蛋白质转化为实际分子的关键步骤。目前,许多提供此服务的公司都加入了一个行业组织——国际基因合成联盟(IGSC),该组织要求他们筛选订单以识别有害分子,如毒素或病原体。

“防御AI生成威胁的最佳方式是拥有可以检测这些威胁的AI模型,”加州南旧金山Twist Bioscience的生物安全负责人、IGSC主席詹姆斯·迪根斯说。

风险评估

政府也在努力应对AI带来的生物安全风险。2023年10月,美国总统乔·拜登签署了一项行政命令,要求对此类风险进行评估,并提出了可能需要对联邦资助的研究进行DNA合成筛选的可能性。

贝克希望政府监管不是该领域的未来——他说,这可能会限制AI设计的蛋白质可能产生的药物、疫苗和材料的发展。迪根斯补充说,由于发展步伐迅速,尚不清楚如何规范蛋白质设计工具。“很难想象一周合适的监管在下一周仍然合适。”

但是,加州斯坦福大学的微生物学家大卫·雷尔曼说,仅由科学家领导的的努力不足以确保AI的安全使用。“自然科学家不能单独代表更广泛的公众利益。”

转载本文请联系原作者获取授权,同时请注明本文来自孙学军科学网博客。

链接地址:https://blog.sciencenet.cn/blog-41174-1424843.html

上一篇:氢气疗法影响蛛网膜下出血铁死亡

下一篇:免疫细胞之间的相互作用