过去的一年中,大模型可谓一夜之间成为了人工智能领域“最亮的那颗星”,无论是通用模型,还是专注绘画生成的模型,抑或是专注音乐生成的模型,惊艳的效果不断震撼着我等凡人。但是目前的大模型无论从基本架构、资源消耗、训练效率还是应用方向上都存在很多问题,都可以作为未来的研究方向。

最近一些关于LLM的综述,其实也都对于LLM的未来有所展望。

比如这篇Large Language Models: A Survey,作者们详细介绍了大模型的发展历程,从早期的预训练语言模型如BERT等,发展到现在的GPT,LLaMA, PaLM等大模型家族。详细讨论了如何构建大模型,包括不同的模型架构、数据清洗、分词、模型预训练、指令微调、对齐等关键技术。总结了目前常用于大模型训练、微调、评估的数据集,并对比分析了一些主流大模型在标准数据集上的性能表现。

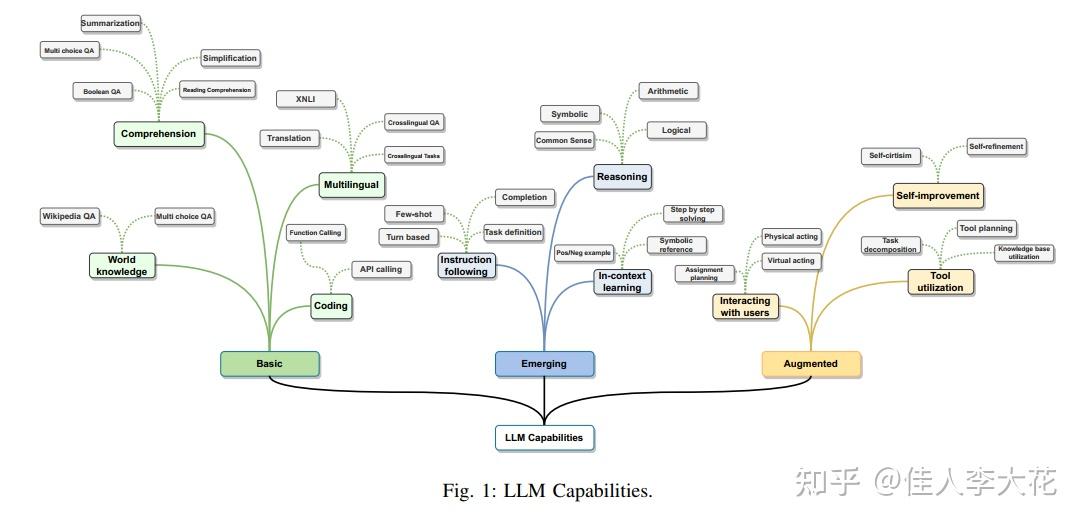

根据作者们的总结,可以看到现在的大模型真的拥有很多很多能力:

比如说几乎所有大模型都具备的基本能力:

- 语言理解能力,如维基百科问答、布尔问答、多选题等任务;

- 语言生成能力,如文本简化、摘要、问题生成等;

- 跨语言能力,如机器翻译、跨语言问答等。

还有不少扩展能力:

- 世界知识:很多大模型可以利用其储备的背景知识来回答问题,无需额外提供知识。

- 工具使用:大模型可以学会使用外部工具,如计算器、搜索引擎等,拓展其能力边界。

- 少样本学习:大模型展现出了强大的少样本学习能力,可以从寥寥几个示例中学习新任务。

- 指令遵循:经过指令微调后,大模型可以遵循自然语言指令执行任务。

此外,还有一些新兴的前沿能力:

推理能力,包括逻辑推理、符号推理、常识推理、算术推理等;

- 任务规划和分解能力

- 与用户交互的能力

- 与外部环境交互的能力,如对虚拟或现实环境采取相应的行动

- 自我修正和迭代优化的能力

当然,目前这些能力还并不完善,其中只有推理能力可以初窥门径,任务规划、环境交互、自我迭代则是通向通用人工智能(AGI)的一些必经之路,仍然有很长的探索之路要走。

文章的最后对于LLM的发展前景进行了展望,作者们认为未来大模型研究的一些重要方向可能包括:

- 更小更高效的语言模型。虽然目前的发展趋势是模型越来越大,很多人“迷信”模型越大,参数越多,性能越好,但随之而来的,却是超高的训练和使用成本。未来一个方向或许是研究如何在保持性能的同时压缩模型体积,提高效率,其中知识蒸馏等技术或将扮演重要角色。

- 超越attention的新型架构。Transformer的attention机制虽然强大,但在处理长文本时却出现效率较低等问题。因此势必需要探索新的更有效的机制,来高效的建模长距离依赖。目前已经有了一些新的尝试,包括S4, Mamba等架构。

- 多模态大模型。未来大模型不仅需要流畅的处理文本,肯定还要满足流畅的处理图像、视频、语音等多种模态数据的需求,这将极大拓展大模型的应用场景。但是从Sora直到现在仍然不能公测也可以推断,多模态模型对于资源和能源的需求恐怕大到难以想象。

- 改进大模型的使用方法及扩展技术。时至今日,大模型仍然有很多局限性,比如如何解决顽固的幻觉问题,以及如何更好的将大模型用于下游任务,仍然需要大量的研究。提示工程、知识检索、工具使用等领域都有很多工作可以做,基于大模型的智能体研究终会走向通用人工智能。

仅仅发展了短短时间的大模型已经给了我们很多震撼,未来到底会发展到怎样的程度真的很难预测。绘画生成模型的“现世”,让不少小画师心有惴惴,生怕自己哪天被AI淘汰;Suno的惊艳让200多位“音乐人”联合发信抵制。但是不管多么不愿意看到大模型“入侵”自己的领域,大模型的发展脚步终究是无人可以阻止的。

作为一个普通人,我们能做的就是努力跟上时代,跟上大模型发展的步伐,当大模型来到面前的那一天,努力的应用它,让它成为自己的助手,而不是成为它的“手下败将”。与其到时候被AI鄙视,不如现在赶紧学起来。建议可以学习一下「知乎知学堂旗下的AGI课堂」推出的【程序员的AI大模型进阶之旅】公开课,邀请一些圈内的大佬,用2天的免费课程,帮助我们快速高效的了解各种通用大模型,通过实践发现各种大模型的优缺点,理解各种各样的参数涵义,未来无论是要进行模型推理还是微调,都不会觉得陌生和慌张,而是成竹在胸的“指使”大模型帮助自己工作。现在直播免费领,很快就没有了,先来占个位置不吃亏~

现在很多大佬们都在关注着大模型的未来“走向”,希望提前“预测”大模型的能力上限,给自己留出充足的准备和学习时间。

比如有大佬尝试使用LLM探索高深的数学问题,成果发表在了Nature上:

文章介绍了一种名为FunSearch的创新方法,它将大语言模型的智能与进化算法的搜索能力巧妙结合,尝试解决复杂的数学和计算机科学问题。研究者使用FunSearch在极端组合数学的cap set问题上取得了突破,找到了之前未知的更优解;在在线装箱问题中,该方法也发现了比传统算法更高效的启发式规则。

作者们认为FunSearch的成功得益于LLM的先验知识、精心设计的搜索空间约束,以及鼓励多样性的进化机制。

除了“入侵”数学界外,还有学者认为未来很多领域都会出现LLM的身影:

比如LLM在医疗领域有广泛的应用前景。它可以用于医疗客服、辅助诊断等方面。一些研究使用GPT进行乳腺肿瘤诊断,与专家诊断有较高的一致性。但是将LLM应用于实际临床仍需谨慎,需要反复验证其医学可靠性,并注意潜在的伦理风险;

比如LLMs有望革新教与学的诸多环节。GPT等模型可以辅助学生进行写作、数学等学科的学习,提供个性化的教学服务。老师可使用LLM半自动批改作业、生成教学内容等,提高教学效率;

比如大语言模型在社交媒体领域可应用于内容生成、审核、舆情分析等。这个就非常常见了,知乎的“知海图AI”也正是因此应用而生的,只是目前LLM生成内容的准确性、导向性等仍需把控;

甚至于,LLMs可以在农业领域有所作为,比如作物优化、灾害预警等。LLMs可以整合土壤、气象等多源数据,为农作物种植提供智能决策。农民可以通过对话式系统获取种植、施肥、病虫防治等个性化建议。

避无可避,便无需再避!既然躲不开大模型向前滚动的车轮,那就努力学起来、用起来,让它成为“助手”而不是“对手”。