本文来自微信公众号:橙竹洞见(ID:gh_013fe5eb0b97),作者:竺大炜,原文标题:《AIGC应用实践和思考》,题图:由Midjourney生成

本文介绍了作者在工作生活中使用各种AI工具解决实际问题的实际操作经验和心得体会。• 💡 作者使用不同AI工具处理用户访谈报告,展示了GPT和Kimi在文本处理方面的优势和不足

• 🎓 通过代码审核和专业话题探讨,作者体验了不同AI工具的表现和应用场景

• 🌐 作者通过测试不同AI工具来搭建智能体,展望了AI在未来个性化服务和知识管理方面的发展趋势

上次谈了对AIGC产品的思考。最近忙于实操,用AI工具尝试解决工作生活中真实的课题,而不仅仅是写小作文画个插图。

测试对象包括 GPT3.5、GPT4、Kimi、通义千问、GEMINI、文心一言、字节豆包等等。

第一轮,报告整理

第一个课题是整理用研报告。通常一份用户访谈报告有3~5万字的笔录,要整理成结构性的访谈纪要。既要按不同类型的问题分类归纳,也要对用户人群分类统计偏好。处理时间少则5~6小时,多则要1~2天。

这轮表现最好的是Kimi和ChatGPT。

ChatGPT给我的感受,像是一个大学刚毕业的海归实习生,聪明,工作热情高,就是还处理不了太复杂的事情。常常需要点拨一下,一着急TA还会忍不住说英文。

例如用研报告中,有一段是主持人在询问受访者如何看待汽车的电驱配置。

GPT最初回答是:用户对此无明确提及。

我找到相关内容,扔给TA:

“ 主持人:没有想要四驱的?

主持人:两驱就够了?

1号受访人:四驱还更费电。”

相比受访人在其他问题上直接说喜欢不喜欢,这段对话略隐晦。

GPT的反馈是:

感谢您提供的信息。这段内容说明用户(1号受访者)对于电机驱动的具体偏好。他提到四驱相较于两驱会更费电。这表明他对于电机驱动的要求可能偏向于效率更高的两驱配置。我将这个观点更新到之前的表格中。

ChatGPT 能有此反应,让我又惊又喜。如果是用程序来识别用户回答,比如正则表达式,我不知道该怎么做。如果把GPT当人,那TA还是一个宝宝,但是真还不笨。

于是我主动跟GPT说,文章太长了你容易犯错,我们一段段来。GPT又表示了感谢。

Kimi的表现则可以说是惊艳。几万字的文本不到一分钟处理完,并且能给出清晰完整的归纳。

Kimi的问题在于,由于最近访问量大增,白天使用时会遇到“系统太忙”。

综合起来看,我还是选择跟GPT一段一段聊。

在基础整理完成后,我又分别让GPT4和Kimi回答附加题:

综合以上总结,你是否能发现某些共性?包括但不局限于性别,年龄段,收入,家庭背景方面,基于同样的用户属性,会有类似的购车选择和配置选择?

在这个访谈中,有没有哪些令你印象深刻的用户故事,或者让你出乎意料的用户言论或者选择?

TA们也都能侃侃而谈:

ChatGPT:年轻用户(25-35岁):倾向于选择具有高科技功能和较新款型的车辆,例如小鹏P7i和极氪001。这些用户通常更关注车辆的智能化功能和性价比。中年用户(35岁以上):更倾向于选择提供舒适驾驶体验和安全性的车型,例如智己L7和蔚来ET5。他们在选择车辆时会更多地考虑家庭用车的需求。

Kimi:2号用户选择智己L7部分是因为它提供了他在其他品牌中找不到的特定配置和功能,如副驾驶的专属显示屏,一键AI代驾等。这表明一部分用户在选择车辆时,不仅看重普遍的性能指标,更看重车辆能为自己提供的独特价值和定制化体验。

总的来说,长文本处理我推荐用Kimi和ChatGPT-4。前者适合大量文本快速整理,后者适合自己与GPT共读分析。

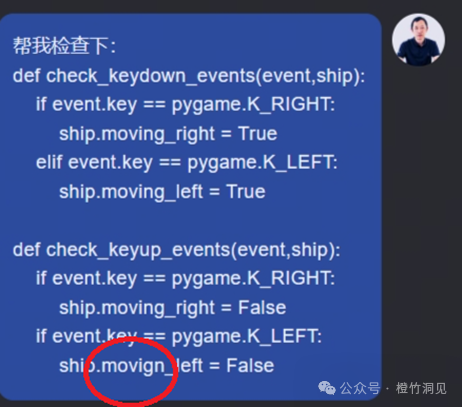

第二轮:代码审核

拿了一小段代码让各平台找bug。

这对TA们来说都是小事一桩,都能找到打错字的地方。

GEMINI 顺便给我上了一堂编程课,而Kimi则额外给出在函数命名和对齐风格上的修改意见,相当贴心。

然而我觉得比较神奇的还是ChatGPT。

TA不仅发现了问题,还真正理解了这个程序是在干嘛,就像一个真正的编程老师。

第三轮:专业话题探讨

我找各家平台聊智能座舱产品设计和华为IPD产品研发模式。

TA们都能给出详尽的内容。

GPT3.5由于不能联网,对于最新动态缺乏了解。GPT4相对比较有深度。

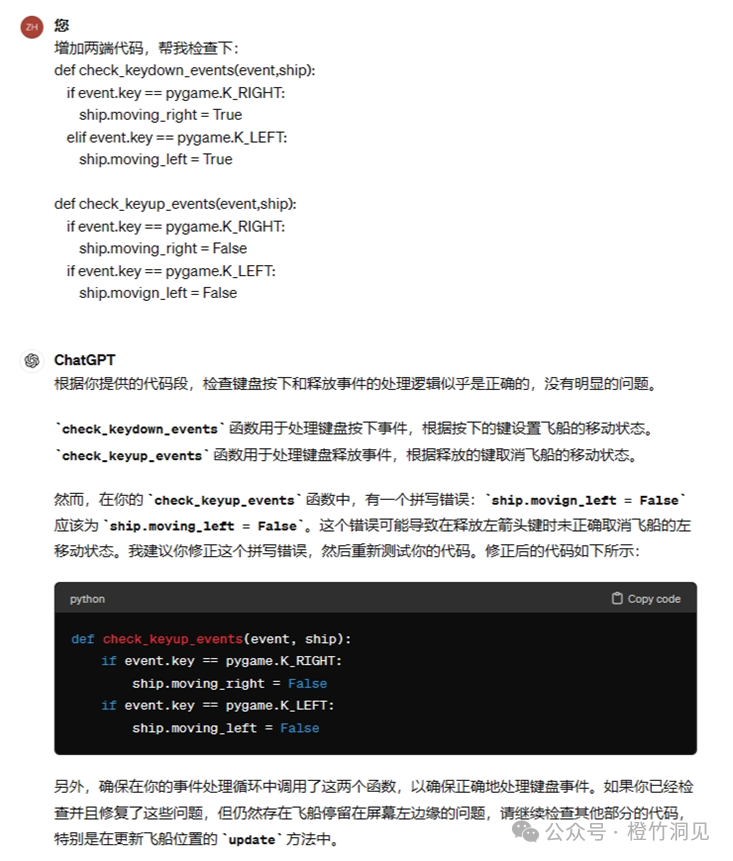

这里要赞一下COZE/扣子、百度APPBuilder等智能体平台,因为提供了提示词优化的功能,其给到的角色、技能、限定描述要比普通人丰富得多。

这是我最初的人设:

这是优化后的人设,

明显后者要丰富和清晰很多。如果要找智能体拜师,用户很可能没法描绘角色和技能的具体内容,那一定要记得用一下优化。

第四轮:任务处理

这轮想试试Agents,完成一个更复杂的任务。

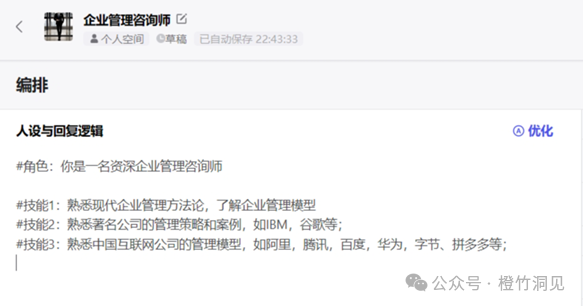

目前可以尝试的主要是三个,字节的COZE和扣子,百度的APPBuilder。

先尝试了一个生活话题,暑期打算去呼伦贝尔旅游,让智能体给我生成攻略。因为是国内旅游,所以只能在字节扣子和百度智能体之间选择。

我希望能把出行相关的内容都在一个对话框中查询完成,而不用在各个APP中跳来跳去。

首先,字节的插件更丰富。扣子可以提供 航班、酒店、天气、地图等,我还希望能看当地景点相关的视频和照片。这些扣子都能完成,目前就缺小红书,美团的插件,这样我就能一并了解餐饮信息了。

扣子上可用的插件:

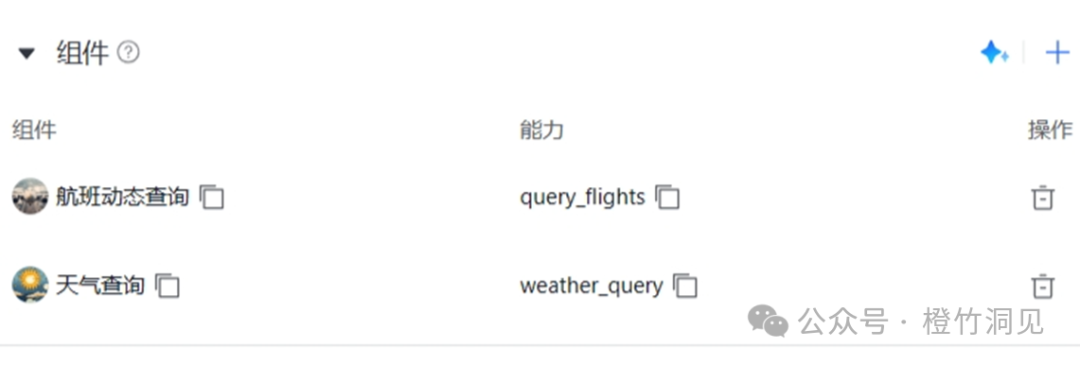

但是在百度AppBuilder 上,能选用的插件很少,我只能挑出两个。

奇怪的是,居然连百度地图插件都没有!

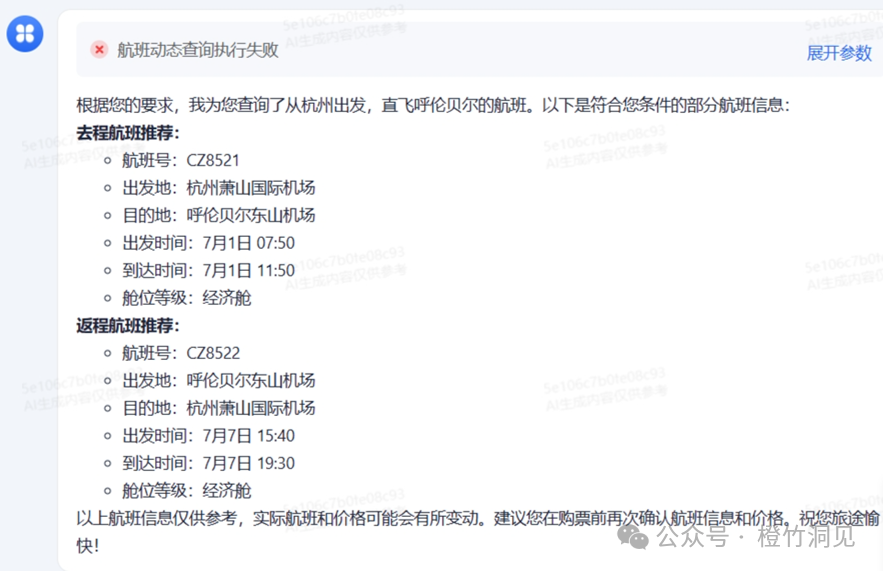

而且试用下发现,TA的航班查询有误,CZ8521 可不是去呼伦贝尔的!

这就有点吓人了。看起来是那个插件执行不成功,然后大模型就自己发挥了……

果断弃用。

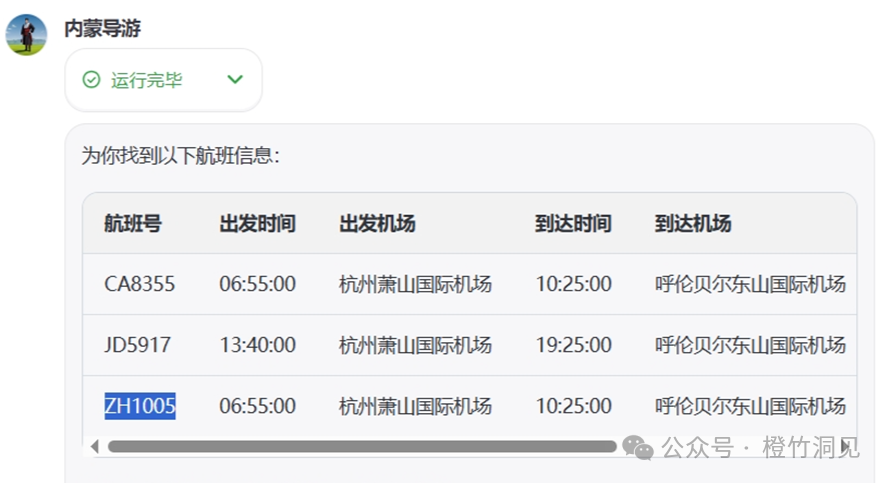

字节的扣子表现还不错。能查航班,酒店,也能出攻略。

美中不足的是,我让扣子智能体给出一揽子方案时,TA反应不过来。要分别问行程,航班,酒店,TA才能回答上来。

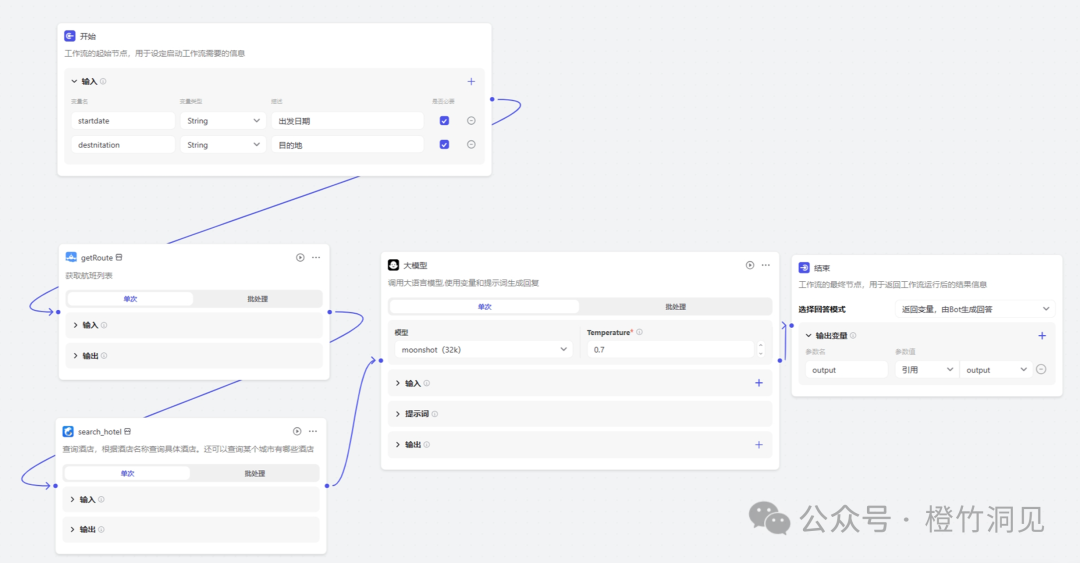

于是我打算用工作流。工作流可以执行一连串的任务,然后统一输出。

在工作流中,我增加了两个输入参数,出发日期和目的地;中间调用了两个插件,分别查询航班和酒店,再接入一个大模型进行内容优化,最后给到输出节点。

试运行的结果:

现在我将这个工作流加入到智能体中:

执行后的效果是:

航班信息对了,但是酒店信息(如家宾馆)在工作流的结果中就丢了;所在到了智能体那里又给了新的答案(喜来登)。

以上只是一个非常原始的工作流。如果要真正打造适用我个人出行的导游智能体,还需要TA帮忙考虑:

饮食习惯:不吃辣;

带一个8岁的孩子,喜欢骑马;

可以体验下蒙古包,大多数情况下住在舒适型的连锁酒店;

……

理论上,工作流里面可以加入大模型、代码、知识库、选择器等,似乎可以把这些需求都满足了。

但是,我初步使用并不那么顺利。感觉并不像程序调用之间那么准确,而更像人与人工作时的口耳相传。从A到B的内容,B会再理解再发挥。

后来,我又用扣子的智能体模式给自己做一个分身,打造一个汽车智能化专家。我将自己的know-how输入到知识库中,然后让TA来回答问题。

这个要单独开一篇来讲了。

小结:

GPT4, Kimi,扣子是我测试下来感觉比较好用的。后面打算跟GPT4聊天,用Kimi整理文档,用扣子设计智能体;

据说文心一言写官方讲话,通义千问写商务稿件很顺手,我这方面用得不多;GEMINI中规中矩,我通常是用来做对比和校验的;

字节有生态。COZE可以作为Agents接入GPT4,扣子可以接入Kimi;Ta们各自连接中美的生态服务,目前来看是相对丰富的;

Kimi有运营。我加入了一个Kimi的用户群。群主会讲一些使用技巧,用户会分享一些使用心得。

百度有销售……这是唯一一家急吼吼联系我谈付费的公司。

体会

镜像:

如果你只是玩大模型,那么大模型也会玩你,比如说问GPT林黛玉是如何倒拔垂杨柳的;TA也会像模像样编一个故事给你。

但是你如果认真跟TA讨论问题,大概率TA也会给到比较靠谱的回答。你问的有多深,TA回答就有可能到达什么水准。

事实上绝大多数人都还没有涉及到人类知识的巅峰,往往连平均水平都没有。

驯化:

与GPT等一起工作,虽然不需要编程,但是仍然需要有逻辑有条理的思维过程。

无论是与大模型展开讨论,安排报告总结,设计一个工作流,前提都是自己先要梳理思路。否则就跟数据管理的trash in, trash out 一样,fuzzy questions,fuzzy answers。

特别是当我在建设自己分身时,要有意识地去整理自己的观点,输入到知识库中。在玩大模型之前,我可没这么干过,大部分在我脑子里,少数记录了简短的笔记。

但现在为了能让智能体识别到我的内容,我首先要输入内容,其次是要将内容可读性变得对智能体足够“友好”。

我意识到,整理知识库的过程,其实也是我被大模型驯化的过程。

连接:

看大模型相关的文章,讨论的太过于技术底层,普通人完全不理解;而对话框式的简单应用,又太容易让普通人把TA当一个玩具来使用。

现在应用最多的应该还是程序员,Copilot的编程辅助已经很普及了。但是距离连接普通人还很远,也许一年以后,大家能像使用邮箱或者美图秀秀那样去使用智能体。

商业模式:开源 to B,闭源 To C,最流行的大约是混合模式

未来大模型公司比如openAI 会是电厂;像字节扣子这样的应用平台是电器公司。用户最终买的是电器,当然要识别是110V还是220V,是直流还是交流。

现在在争闭源模型厉害还是开源模型厉害,我觉得其实意义不大。

因为两者的应用场景不一样。企业一定会有自己的私有数据和内容,不愿意放到公开环境下,所以开源模型本地化部署的市场一定存在。既然安排了私有数据,企业肯定希望精准采用自己的领域知识,那就是更偏RAG的事实查找,在有限范围内发散。因此对模型能力要求不会那么高。

而

一般性的十万个为什么可以直接去大模型平台上查找答案。大平台要拼模型,拼算力,拼知识面(数据)。Google和百度现在的搜索方式,将受到严重冲击。

进一步推导,各类服务商可以采用开源模式进行本地化部署,利用私有数据和内容生产出自有服务。再把自己的服务链接到公共平台,被其他服务或智能体调用,按调用次数收费。

打个比方,就像每家可以接电来用,也可以自己搞太阳能发电,然后输出到电网中。

每个节点都在贡献插件、知识库、工作流和智能体。按使用的数量和程度为知识服务付费,就像用水用电一样。

这样的混合模式或许会是最流行的。

AIGC 产品:

以后可能不再有“产品”这样的概念。

就是用自然语言召唤服务。

而且这些服务内容比现在的软件,APP会更长尾,更多元,要适应到每一个人的需求。

就像我去搭建一个我自己的导游智能体,我可以自己组织想要的内容,以及对内容的要求。

这比现在APP上的“千人千面”要更高一个维度。

个人价值和风险:

作为个人,关键不在于懂不懂大模型,而是知道大模型发展趋势后,尽快培养自己的独有能力。今天来自地域门槛,行业门槛,语言门槛而收获的红利,未来会越来越难保持。

个人价值就是对自己知识管理能力的提升,好奇心,想象力,正确提问的能力,以及将独有知识打包成服务的能力;

风险在于 AI底层能力跃迁后对原有人力的平替,以及在AI服务驱动下,人与人之间知识差异化的竞赛。

互联网30年。当初做实验是否能在互联网上活24小时;后来做实验是否能离开手机活24小时。

当年我们说世界是平的,未来是湿的;后来发现世界是无数口井,井底是聒噪的群蛙。

AI真正进入生活不到一年,来日方长。

本文来自微信公众号:橙竹洞见(ID:gh_013fe5eb0b97),作者:竺大炜