GitHub

资料暨AI业者Databricks周三(3/27)开源了通用大型语言模型(LLM)DBRX,宣称DBRX在各式标准的基准测试上超越了坊间所有的开源模型,也在大多数的基准测试上击败GPT 3.5。

DBRX是个基于Transformer解码器的大型语言模型,采用细粒度的混合专家(Mixture of Experts,MoE)架构,具备1,320亿个参数,当中有360亿个经常处于活动状态,于12T Token的文字与程式码资料上进行预训练。

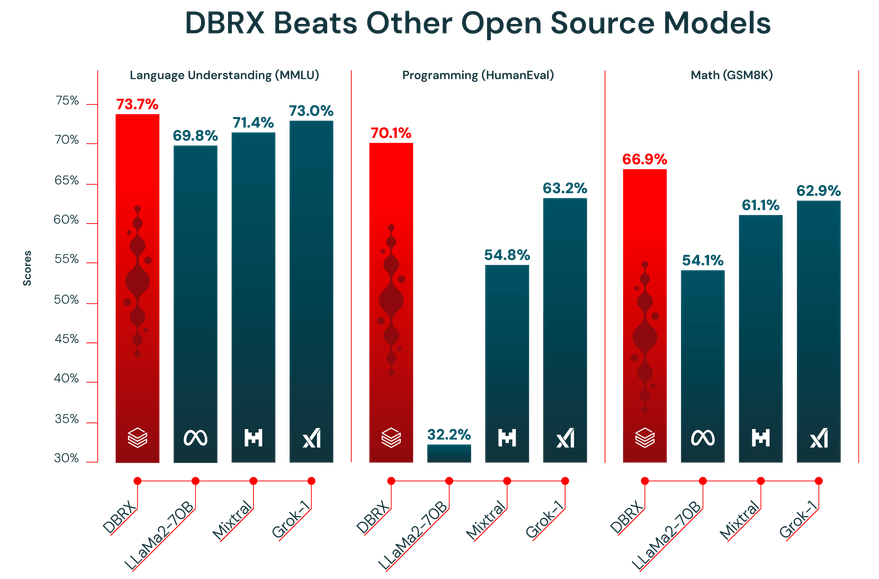

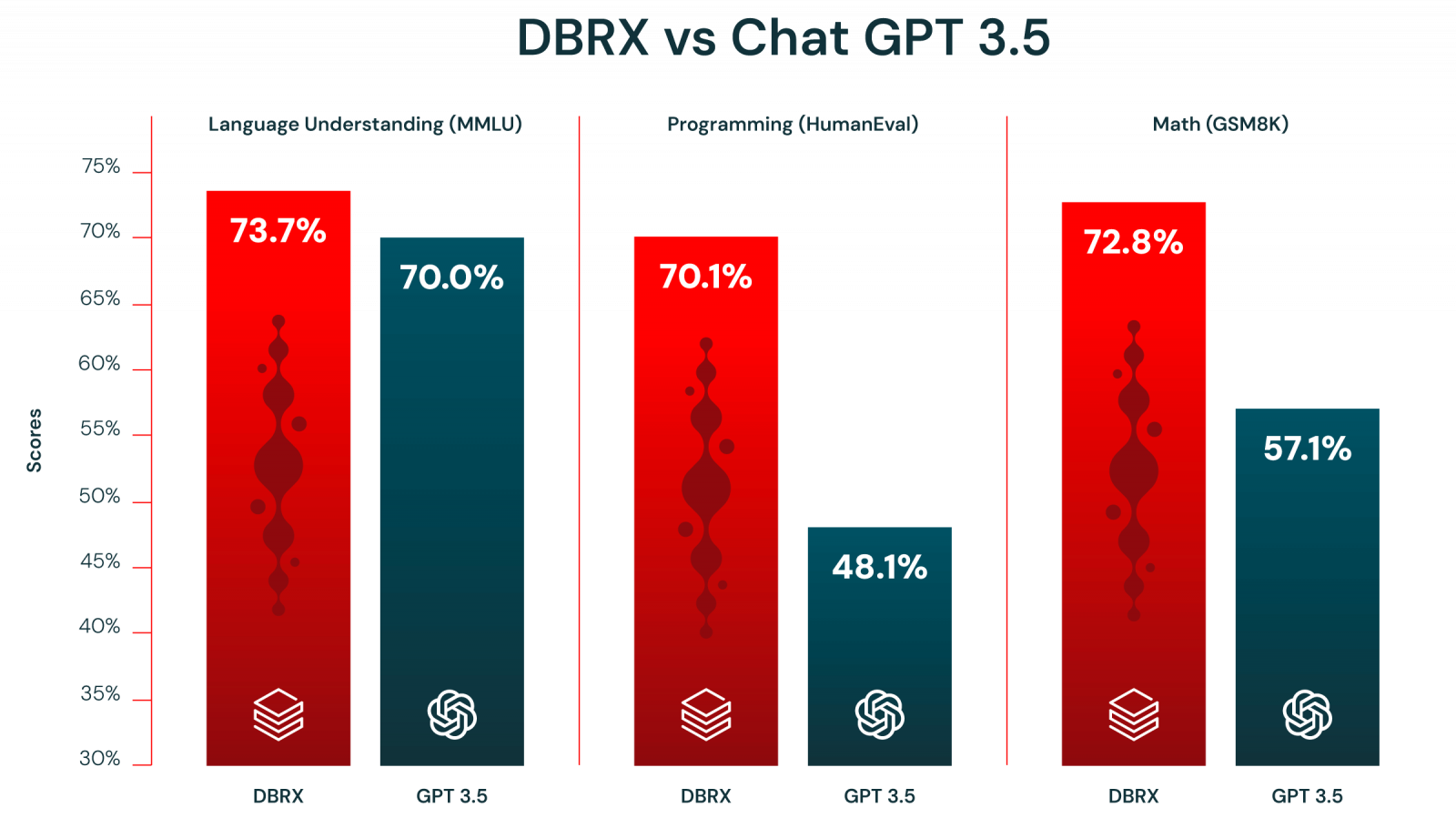

相较于市场上既有的LLaMA2-70B、Mixtral和Grok-1等开源模型,DBRX在语言理解(MMLU)、程式设计(HumanEval)及数学逻辑(GSM8K)等基准测试上的表现明显胜出。此外,DBRX在上述3项基准测试中亦凌驾OpenAI的GPT 3.5。

若比较更高阶的GPT 4、Claude 3及Gemini 1.0 Pro,那么DBRX在语言理解上赢过Gemini 1.0 Pro,在程式设计上赢过GPT 4与Gemini 1.0 Pro。

Databricks亦强调,DBRX是个采用MegaBlocks研究与开源专案的混合专家(MoE)模型,得以实现快速的Token处理能力,也相信未来将有更多的开源模型采用MoE架构,因为MoE可用来训练更大的模型,并以更快的吞吐量来提供服务。

Databricks生成式AI副总裁Naveen Rao 向《TechCrunch》透露,该公司花了两个月及1,000万美元的成本来训练DBRX,而经过训练的DBRX可提供各种主题,现已针对英文进行优化,但也支援法文、西班牙文与德文。

不过,《TechCrunch》也指出,一般人并不容易使用DBRX,因为要执行DBRX至少必须配备4个Nvidia H100 GPU或其它GPU,且光一个H100的成本就高达数万美元,对许多开发者或个人企业家而言是遥不可及的。