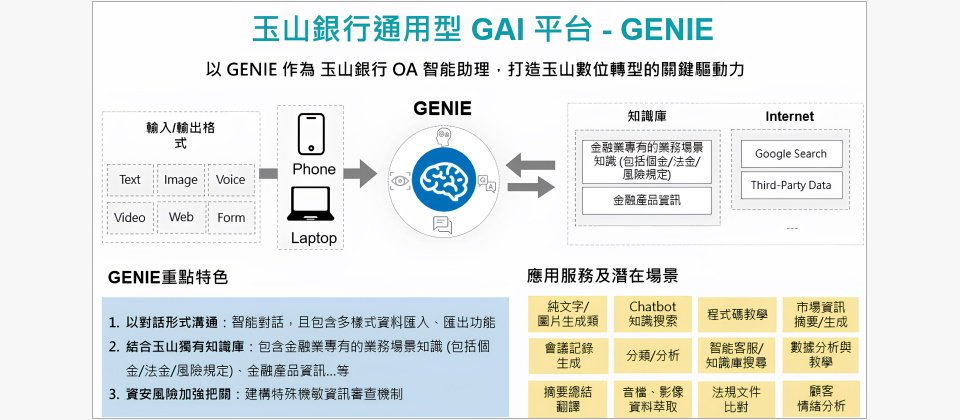

玉山在内部推出通用型GenAI平台GENIE,这个平台本身是一支API,当使用者在GENIE的介面输入资料后,资料会通过GENIE连接至微软提供的Azure OpenAI服务,再通过GENIE回传模型生成的结果给使用者。(图片来源/玉山金控)

玉山金控不只是台湾金融业率先拥抱生成式AI的领先者,更不到2年,就打造一个GenAI平台,可透过API方式,整合到不同的应用场景和内部系统中,让生成式AI更容易落地到多种工作流程中。目前,玉山内部启用了11项生成式AI应用服务,还有1项正在开发中。他们能够快速将生成式AI落地的关键就是,今年初正式启用的通用型GenAI平台GENIE。

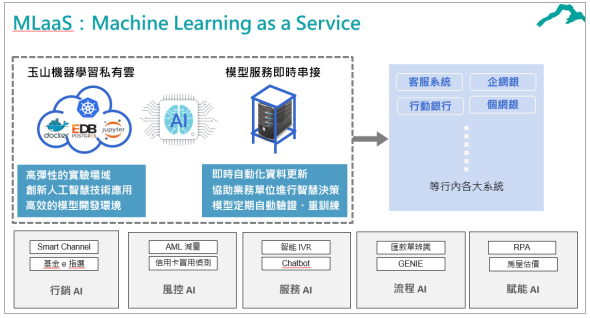

五年前,玉山就自建一套机器学习即服务平台MLaaS,几年下来,平台提供和维运了AI五大类服务,包括行销AI、风控AI、服务AI、流程AI以及赋能AI,GENIE平台就是流程AI类的其中一只API。这个平台有两大特色:API化服务和检索增强生成(RAG)技术。一方面,GENIE是一只独立的API,可以整合到多种延伸应用服务,内部系统可以透过API串接来使用GENIE的功能。另一方面,玉山自建丰富的金融知识库,藉RAG技术,来提升LLM模型回应金融领域问题的精准度。

除了API串接形式,GENIE平台还提供一个前端介面,可以直接提供使用者自己操作来使用,类似ChatGPT介面风格,支援多种资料汇入和汇出的格式,包括文字、图片、声音,和档案等格式资料。当使用者输入资料,资料会通过GENIE连接至微软Azure OpenAI服务,再通过GENIE回传结果给使用者。

由于GENIE平台需要将资料传送到外部服务,因此,玉山除了使用供应商提供的护栏服务,过滤使用者输入资料和模型生成回应,他们也额外开发机敏资料扫瞄机制,采用等价交换的方式,例如将身分证字号换成随机号码,避免机敏资料外泄。

不同于以往应对资安风险采用的遮罩技术,玉山选择采用等价交换,是为了确保LLM模型能正常运作。玉山银行智能金融处资深副总工程师林钲育解释,遮罩技术是将机敏资讯遮蔽,防止重要资料外泄,但是,LLM模型需要根据上下文资讯进行判断,若只提供遮蔽后的片段文本资讯,可能削弱模型的理解能力,进而影响模型正常提供服务。反之,等价交换的方式不仅能保护敏感资讯,也可以减少对模型判断力的影响。

早在2023年上半年,玉山就已经确立好GENIE平台架构,同时开发介面,建立资料外泄机制。不过,他们并没有立即投入开发应用服务,而是先大规模的搜集潜在应用场景。

玉山从2018年开始打造MLaaS平台,以MLaaS为核心发展出行销AI、风控AI、服务AI、流程AI、赋能AI五大领域AI服务,全行运作超过百支AI服务。其中,GENIE平台被设计为一支API,归类于流程AI领域。(图片来源/玉山金控)

建立行内知识库前,以「工人智慧」逐一检视百万笔输入资料

2023年下半年,玉山向行员释出GENIE平台测试版,供行员查询、试用各项服务。起初,GENIE平台仅纯粹介接LLM模型服务,并未额外设置知识库提升回应精准度。目的是为了搜集足够的查询需求,再根据使用者的需求开发进阶应用服务,建立全行知识库。

为了提升业务单位使用新技术的意愿,在测试阶段初期,玉山团队也举办工作坊和教育训练,教导行员使用生成式AI工具,同时促进行员发想更多使用场景,「我们有点像工人智慧,逐笔看大家的输入纪录。」玉山银行智能金融处副主任工程师徐铭霞回忆,当时收到超过百万笔输入纪录,团队逐渐摸索出使用者关注的问题和潜在应用场景,协助后续导入知识库和开发进阶应用服务时,能更有效决策优先开发顺序。

因应金融业务资讯快速变动,以RAG作为GENIE技术核心

经过初期测试阶段后,玉山接著建立包括金融产品资讯,以及涵盖个金、法金和风险规定等业务场景知识的知识库,透过GENIE连接至LLM模型服务,供模型检索资料,生成更精准的回应。玉山团队在微调(Fine-tuning)和RAG技术两者之间,选择RAG作为发展生成式AI的关键技术核心。为什么?

首先,金融产品知识更新频率快,十几张信用卡资讯可能在一个月内就发生变动,微调模型不仅耗时,跟不上产品资讯变动,还须要投入大量成本。再来,若资料量过少或品质太低,微调模型表现也不好。反之,采用RAG能够让模型检索最新资讯,有助于快速应变资料异动,甚至做到即时更新。

在发展RAG时,玉山选择在建立知识库的阶段投入最多技术能量。

林钲育解释,RAG技术的运作有三个关键步骤,建立知识库、检索到监控输出内容。建立知识库的过程中,先透过嵌入技术将大量文字转为向量,以供模型检索之用。其次,在检索时,将LLM模型视为逻辑引擎,让LLM模型根据使用者提出的问题来检索文件,找出最符合答案,最后是再透过闸道(Gateway)来进行监控,作为输出前的防线,来控管LLM模型生成的答案,筛选过后才能提供给使用者。

这三个步骤当中,玉山花最多力气在第一个步骤,「东西给的对,后面就八九不离十。」林钲育说,玉山发展RAG的策略是,在建立知识库时,尽可能切出准确的向量距离,来提升资料检索的精准度,如此一来,也能尽量降低模型回应错误率。

使用LLM模型容易会有遭模型绑定的问题,因为不同LLM模型产生的向量有异,相似度判断结果也可能有所差异,一但更换所用的LLM模型,就得重新生成所有文件的向量。因此,除了使用嵌入技术,玉山团队也考虑采用术语库(term base)来进行资料检索,例如,关键字搜索,或使用TF-IDF或BM25等特定演算法。这个方式虽然传统,却能解决依赖单一模型的问题,不需要额外生成向量,只要有明确词汇就能进行检索。

GENIE整合流量管控和财务管理机制,下一步是走向混合云架构

而在去年下半年的测试期间,玉山团队除了观察使用者需求,也将流量管控和财务管理机制纳入平台,纪录各单位使用频率和流量。他们沿用玉山既有的API流量管控机制架构,改成管控LLM使用流量,以及计算服务使用花费。

玉山团队的作法,是在平台连接供应商服务的流程中设置流量管控机制,针对玉山全部系统进行管控,如此一来,团队可以观察不同单位使用情况,以及不同模型的长处和应用情况,协助开发团队日后应对不同使用者需求,甚至在未来将生成式AI推向服务时,开发团队也能根据不同服务需求选用适当的LLM模型。

实际观察LLM使用流量后,挑战还在后头。「一旦跟业务嵌入后,就会有旺季淡季的议题。」林钲育坦言,业务单位的高低峰使用量增加不少流量管控的难度。因此,为了提升平台的弹性,玉山团队正在计划将云端纳入GENIE平台的调度环境,采用容器和K8s,运用K8s平台的自动扩充机制,根据当下流量即时调度运算资源,协助进行流量管控。

近期金管会松绑上云规范,开放金融机构能将非涉及重大消金业务的系统迁至公云,玉山团队也开始筹划让GENIE平台的架构能上公云,把平台转为混合云架构。预计最快年中就会推出新一代的通用型GenAI平台。

传统AI和生成式AI的开发维运模式不一样

2018年,玉山定调全力发展AI,五年的耕耘让玉山内部累积不少AI开发维运经验,但是,导入生成式AI仍和过往发展AI不太一样,也让玉山面临不少挑战。玉山银行智能金融处副主任工程师徐铭霞解释,过往玉山大多使用自己建立的模型,但自从LLM模型服务上线后,企业开始需要向外部流通资料,「那资料外泄的议题要怎么样做处理?我们跟云端厂商要怎么合作?」这些考验,需要额外设立规范或建立机制才能解决。

除了资料外泄和云端厂商合作议题,控管云端服务花费也是一门学问。徐铭霞解释,过去团队在计算开销时,仅需要计算硬体设备或扩充VM等既有且已知的价格,「可是未来用到云端服务,它的价格就会依照云端业者提供。」等同是使用完服务,才能得知具体花费,无法提前交出预算。因此,玉山团队在开发生成式AI应用时,也需要额外设置卡控机制,控制服务开销。

另外,发展生成式AI应用和过往发展AI模型应用场景也有所差异。徐铭霞指出,LLM模型类似一个7岁小孩,拥有许多知识,可以发展许多通用型的场景,和过往使用单一模型、发展特定场景的开发模式不同,因此,如何筛选适当导入生成式AI的场景,就是一项考验。